Die Sicherheit von auf künstlicher Intelligenz basierenden Kryptowährungen

Die Sicherheit von auf künstlicher Intelligenz basierenden Kryptowährungen dreht sich nicht mehr nur um Smart Contracts und private Schlüssel. Wenn ein Token, Protokoll oder „Krypto-Produkt“ von KI-Modellen abhängt – Preisprognosen, Risikobewertungen, automatisiertes Market Making, Liquidationslogik, Betrugserkennung oder autonome Agenten – erben Sie zwei Sicherheitsuniversen gleichzeitig: Blockchain-Sicherheit und KI/ML-Sicherheit. Das Schwierige ist, dass diese Universen unterschiedlich ausfallen: Blockchains versagen lautstark (Exploits on-chain), während KI-Systeme oft leise fehlschlagen (schlechte Entscheidungen, die „plausibel“ aussehen). In diesem Leitfaden erstellen wir ein praktisches Bedrohungsmodell und einen Verteidigungsplan, den Sie anwenden können – und zeigen, wie ein strukturierter Forschungsworkflow (zum Beispiel unter Verwendung von SimianX AI) Ihnen hilft, Annahmen zu validieren und blinde Flecken zu reduzieren.

Was zählt als „auf KI basierende Kryptowährung“?

„Auf KI basierende Kryptowährung“ wird online locker verwendet, daher beginnt die Sicherheitsanalyse mit einer klaren Definition. In der Praxis fallen Projekte meist in eine (oder mehrere) Kategorien:

1. KI im Protokoll: KI beeinflusst direkt die On-Chain-Logik (z. B. Parameter-Updates, dynamische Gebühren, Risikolimits, Sicherheitenfaktoren).

2. KI als Oracle: Ein Off-Chain-Modell liefert Signale, die Verträge speisen (z. B. Volatilität, Betrugsscores, Risikostufen).

3. KI-Agenten als Betreiber: Autonome Bots verwalten die Treasury, führen Strategien aus oder übernehmen Keeper/Liquidationen.

4. KI-Token-Ökosysteme: Der Token incentiviert Daten, Rechenleistung, Modelltraining, Inferenz-Marktplätze oder Agentennetzwerke.

5. KI-gebrandete Tokens (marketinggetrieben): Minimale KI-Abhängigkeit; Risiko liegt hauptsächlich in Governance, Liquidität und Smart Contracts.

Sicherheitsfazit: Je stärker KI-Ausgaben den Werttransfer beeinflussen (Liquidationen, Mint/Burn, Sicherheiten, Treasury-Bewegungen), desto mehr müssen Sie die KI-Pipeline als kritische Infrastruktur behandeln und nicht als „nur Analytik“.

In dem Moment, in dem ein Modelloutput On-Chain-Zustandsänderungen auslösen kann, wird die Integrität des Modells zur Geldintegrität.

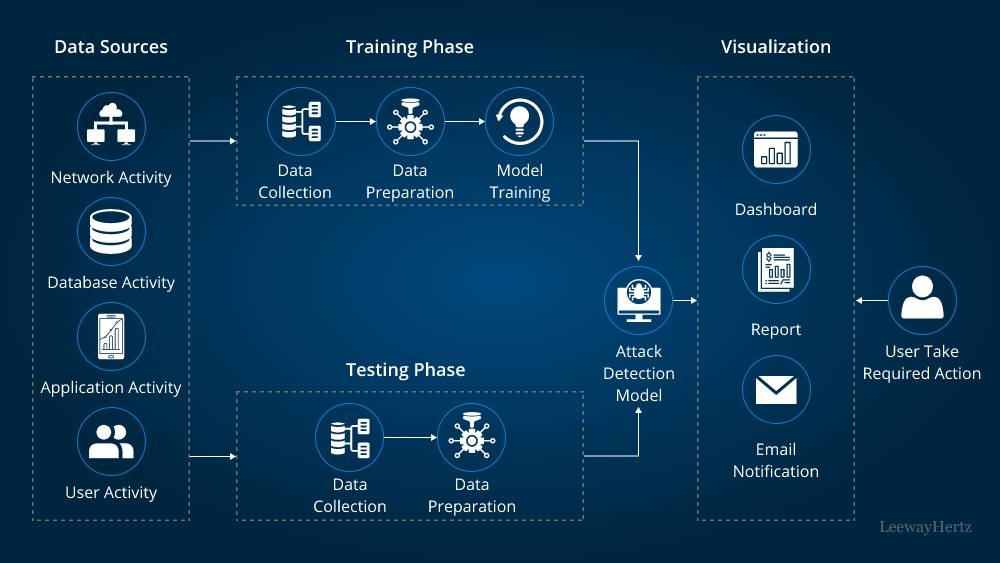

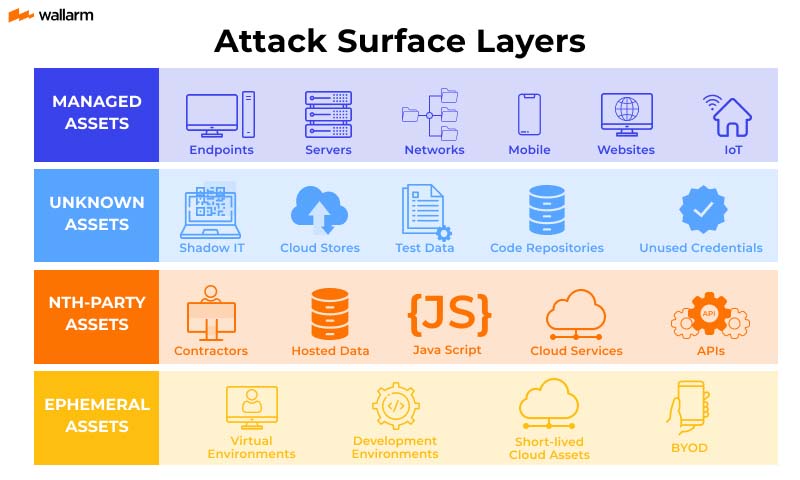

Ein geschichtetes Bedrohungsmodell für KI-basierte Krypto-Sicherheit

Ein nützliches Framework ist es, KI-basierte Krypto-Systeme als fünf ineinandergreifende Schichten zu betrachten. Sie benötigen Kontrollen in jeder Schicht, da Angreifer die schwächste wählen.

| Layer | Was es umfasst | Typische Fehlermodus | Warum es in KI-basierter Krypto einzigartig ist |

|---|---|---|---|

| L1: On-Chain-Code | Verträge, Upgrades, Zugangskontrolle | ausnutzbarer Fehler, Missbrauch durch Admins | Werttransfer ist irreversibel |

| L2: Orakel & Daten | Preisfeeds, On-Chain-Ereignisse, Off-Chain-APIs | manipulierte Eingaben | KI hängt von Datenqualität ab |

| L3: Modell & Training | Datensätze, Labels, Trainingspipeline | Poisoning, Backdoors | Modell kann „korrekt aussehend“ aber falsch sein |

| L4: Inferenz & Agenten | Endpunkte, Agenten-Tools, Berechtigungen | Prompt-Injektion, Tool-Missbrauch | Agenten-“Entscheidungen” können erzwungen werden |

| L5: Governance & Betrieb | Schlüssel, Multisig, Monitoring, Incident Response | langsame Reaktion, schwache Kontrollen | die meisten „KI-Fehler“ sind operationell |

Kernsicherheitsrisiken (und was KI-basierte Krypto anders macht)

1) Schwachstellen in Smart Contracts dominieren weiterhin—KI kann die Auswirkung verstärken

Klassische Probleme (Re-Entrancy, Fehler bei Zugangskontrollen, Upgrade-Bugs, Orakel-Manipulation, Präzision/Rundung, MEV-Exposition) bleiben auf Platz 1. Der KI-Twist ist, dass KI-gesteuerte Automatisierung diese Fehler schneller und häufiger auslösen kann, insbesondere wenn Agenten rund um die Uhr operieren.

Abwehrmaßnahmen

2) Oracle- und Datenmanipulation—jetzt mit „KI-freundlicher“ Vergiftung

Angreifer müssen nicht immer die Chain brechen; sie können die Eingaben des Modells beeinflussen:

Dies ist Datenvergiftung, und sie ist gefährlich, weil das Modell weiterhin normale Metriken bestehen kann, während es heimlich attacker-wahlverhalten lernt.

Abwehrmaßnahmen

Wenn Sie nicht nachweisen können, woher die Eingaben des Modells stammen, können Sie nicht nachweisen, warum das Protokoll sich so verhält, wie es tut.

3) Adversarial-ML-Angriffe—Evasion, Backdoors und Modellauslesung

KI-Modelle können auf Weisen angegriffen werden, die nicht wie traditionelle „Hacks“ aussehen:

Abwehrmaßnahmen

Ratenbegrenzung, Authentifizierung, Anomalieerkennung, Abfragebudgets.4) Eingabeaufforderungsinjektion und Tool-Missbrauch bei KI-Agenten

Wenn Agenten Tools aufrufen können (Handel, Brücke, unterschreiben, Governance posten, Parameter aktualisieren), können sie angegriffen werden durch:

Abwehrmaßnahmen

5) Governance & Betriebssicherheit—immer noch der einfachste Weg zum Eindringen

Selbst der beste Code und die besten Modelle scheitern, wenn:

Abwehrmaßnahmen

Wie sicher sind auf künstlicher Intelligenz basierende Kryptowährungen wirklich?

Ein praktisches Bewertungsraster (für Entwickler + Investoren)

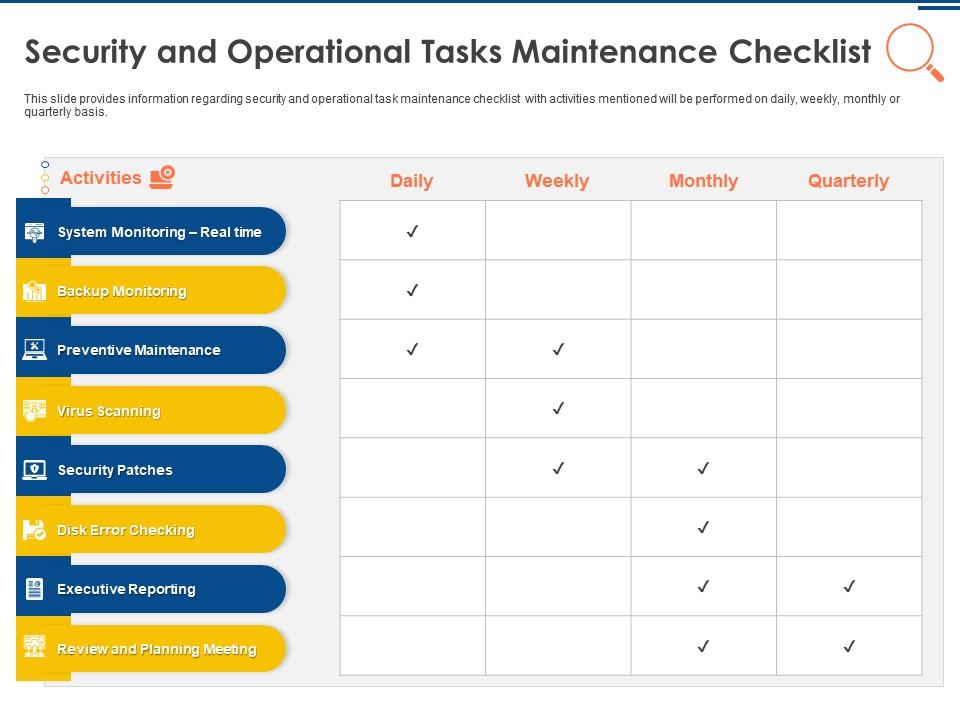

Verwenden Sie diese Checkliste, um reale Projekte zu bewerten. Sie benötigen keine perfekten Antworten—Sie benötigen überprüfbare Beweise.

A. On-Chain-Kontrollen (Muss-Kriterien)

B. Daten- und Orakel-Integrität (KI-kritisch)

C. Modell-Governance (KI-spezifisch)

D. Agentensicherheit (wenn Agenten Aktionen ausführen)

E. Ökonomische und Anreiz-Sicherheit

Eine einfache Bewertungsmethode

Weisen Sie jeder Kategorie 0–2 Punkte zu (0 = unbekannt/unsicher, 1 = teilweise, 2 = starke Beweise). Ein Projekt mit <6/10 sollte als „experimentell“ betrachtet werden, unabhängig vom Marketing.

1. On-Chain-Kontrollen (0–2)

2. Daten/Orakel (0–2)

3. Modell-Governance (0–2)

4. Agentensicherheit (0–2)

5. Anreize/Ökonomie (0–2)

Defensive Architektur-Muster, die tatsächlich funktionieren

Hier sind Muster, die in Hochsicherheits-Systemen verwendet werden, angepasst für KI-basierte Kryptowährungen:

Muster 1: „KI schlägt vor, deterministische Regeln entscheiden“

Lassen Sie das Modell Parameter vorschlagen (Risikostufen, Gebühränderungen), aber erzwingen Sie Änderungen mit deterministischen Einschränkungen:

p > Schwelle)Warum es funktioniert: selbst wenn das Modell falsch liegt, schlägt das Protokoll sanft fehl.

Muster 2: Multi-Source, Multi-Model-Konsens

Anstatt sich auf ein Modell zu verlassen, verwenden Sie Ensemble-Checks:

Dann Konsens erzwingen (oder verlangen, dass der „Disagreement Score“ unter einem Limit liegt).

Warum es funktioniert: einen Pfad zu vergiften wird schwieriger.

Muster 3: Sichere Datenlieferkette

Behandeln Sie Datensätze wie Code:

Warum es funktioniert: die meisten KI-Angriffe sind Datenangriffe.

Muster 4: Agenten-Berechtigungspartitionierung

Trennen Sie:

Warum es funktioniert: Prompt-Injection wird weniger fatal.

Schritt-für-Schritt: Wie man ein KI-basiertes Krypto-Projekt auditieren kann (schnell, aber ernsthaft)

1. Werttransfer-Pfade kartieren

2. KI-Abhängigkeiten identifizieren

3. Datenpipeline nachverfolgen

4. Manipulation testen

5. Modell-Governance überprüfen

6. Agentenberechtigungen prüfen

7. Überwachung und Reaktion validieren

8. Anreize bewerten

Profi-Tipp: Ein strukturierter Forschungsworkflow hilft, fehlende Verbindungen zwischen den Ebenen zu vermeiden. Zum Beispiel kann eine SimianX AI-ähnliche Multi-Agenten-Analyse genutzt werden, um Annahmen zu trennen, Kreuzprüfungen durchzuführen und eine überprüfbare „Entscheidungsspur“ beim Bewerten KI-gesteuerter Krypto-Systeme zu behalten – besonders wenn Narrative und Daten sich schnell ändern.

Häufige „Security-Theater“-Warnsignale bei KI-basierter Kryptowährung

Achten Sie auf folgende Muster:

Sicherheit ist keine Feature-Liste. Sie ist der Beweis, dass ein System sicher ausfällt, wenn die Welt feindlich agiert.

Praktische Tools und Workflows (wo SimianX AI passt)

Selbst mit soliden technischen Kontrollen benötigen Investoren und Teams wiederholbare Methoden zur Risikobewertung. Ein guter Workflow sollte:

Du kannst SimianX AI als praktisches Framework nutzen, um diesen Prozess zu strukturieren – insbesondere, indem du Fragen in Risiken, Datenintegrität, Modell-Governance und Ausführungsbeschränkungen unterteilst und konsistente Forschungsnotizen erstellst. Wenn du Inhalte für deine Community veröffentlichst, hilft das Verlinken unterstützender Forschung den Nutzern, sicherere Entscheidungen zu treffen (siehe SimianX’ Crypto-Workflow-Story-Hub für Beispiele strukturierter Analyseansätze).

FAQ Zur Sicherheit von auf künstlicher Intelligenz basierenden Kryptowährungen

Was ist das größte Sicherheitsrisiko bei auf KI basierenden Kryptowährungen?

Die meisten Fehler kommen immer noch von Smart Contract- und Betriebssicherheit, aber KI fügt eine zweite Fehlerquelle hinzu: manipulierte Daten, die „gültig aussehende“, aber schädliche Entscheidungen verursachen. Du benötigst Kontrollen für beide Ebenen.

Wie kann ich feststellen, ob ein KI-Token-Projekt KI sicher verwendet?

Achte auf Beweise: Modellversionierung, Datenherkunft, adversariale Tests und klare Fehlerquellen (was passiert, wenn Daten fehlen oder das Vertrauen gering ist). Wenn nichts davon dokumentiert ist, behandle „KI“ als Marketing.

Wie kann man KI-basierte Krypto-Projekte überprüfen, ohne tausende Zeilen Code zu lesen?

Beginne mit einem schichtweisen Bedrohungsmodell: On-Chain-Kontrollen, Daten/Orakel, Modell-Governance und Agentenberechtigungen. Wenn du nicht nachvollziehen kannst, wie KI-Ausgaben den Werttransfer beeinflussen, kannst du das Risiko nicht bewerten.

Sind KI-Handelsagenten sicher, um auf Krypto-Märkten zu laufen?

Sie können es sein, aber nur mit geringsten Berechtigungen, erlaubten Aktionen, Rate-Limits und menschlichen Genehmigungen für hochwirksame Bewegungen. Gib einem Agenten niemals uneingeschränkte Signaturbefugnisse.

Macht Dezentralisierung KI in Krypto sicherer?

Nicht automatisch. Dezentralisierung kann Einzelpunkte des Versagens reduzieren, aber sie kann auch neue Angriffsflächen schaffen (böswillige Mitwirkende, vergiftete Datenmärkte, Anreiz-Exploits). Die Sicherheit hängt von Governance und Anreizen ab.

Fazit

Die Sicherheit von KI-basierten Kryptowährungen erfordert eine breitere Denkweise als traditionelle Krypto-Audits: Sie müssen Code, Daten, Modelle, Agenten und Governance als ein System absichern. Die besten Designs gehen davon aus, dass Eingaben adversarial sind, begrenzen den Schaden falscher Modellausgaben und erfordern reproduzierbare Beweise – nicht nur Intuition. Wenn Sie eine wiederholbare Methode zur Bewertung von KI-gesteuerten Krypto-Projekten wünschen, erstellen Sie einen checklistengesteuerten Workflow und halten Sie eine klare Entscheidungsdokumentation fest. Sie können strukturierte Analyseansätze und Forschungstools auf SimianX AI erkunden, um Ihre KI-Krypto-Sicherheitsüberprüfungen konsistenter und nachvollziehbarer zu gestalten.