DeFiデータ分析のためのAI:実践的なオンチェーンワークフロー

DeFiデータ分析のためのAI:実践的なオンチェーンワークフローは、透明だが混沌としたブロックチェーン活動を再現可能な研究に変えることについてです:クリーンなデータセット、防御可能な特徴、テスト可能な仮説、そして監視されたモデル。もしあなたがTVLダッシュボード、利回りページ、トークンチャートを見て「これは手探りのように感じる」と思ったことがあるなら、このワークフローがあなたの解毒剤です。そして、SimianX AIが多段階の研究ループをフレームする方法のように、構造化された段階的分析が好きなら、同じ規律をオンチェーン作業に持ち込むことで、結果が説明可能で、プロトコル間で比較可能で、簡単に反復可能になります。

なぜオンチェーンデータ分析は見た目よりも難しく(そして優れている)のか

オンチェーンデータは、何が起こったのかの真実の基盤を提供します:送金、スワップ、借入、清算、ステーキング、ガバナンス投票、そして手数料の流れ。しかし「真実の基盤」は「簡単な真実」を意味するわけではありません。DeFiアナリストは次のような問題に直面します:

利点は非常に大きいです:AI対応のパイプラインを構築すると、証拠をもって質問に答えることができ、雰囲気ではなく、条件が変わるたびに同じワークフローを再実行し続けることができます。

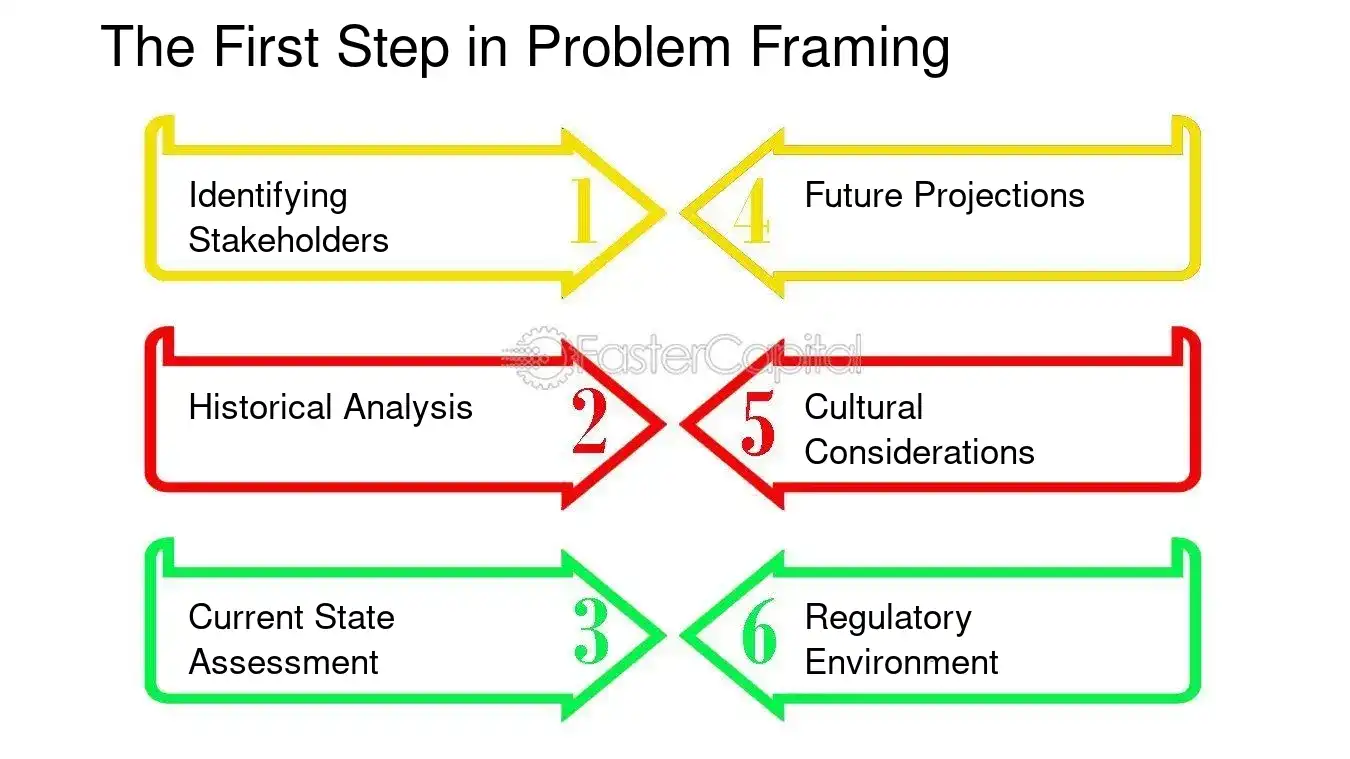

ステップ0: データセットではなく決定から始める

DeFiで時間を無駄にする最も早い方法は、「すべてをダウンロードして」パターンが現れることを期待することです。代わりに、次のことを定義します:

1. 決定: 分析に基づいて何を異なることをしますか?

2. 対象: プロトコル、プール、トークン、ボールト戦略、またはウォレットコホート?

3. 時間の視野: 日内、週次、四半期?

4. 成果指標: 成功または失敗と見なされるものは何ですか?

AIにうまくマッピングされる例の決定

重要な洞察: ターゲットが測定可能なときにAIは最も強力です(例:ドローダウン確率、清算頻度、手数料対排出量比)、ターゲットが「良い物語」のときではありません。

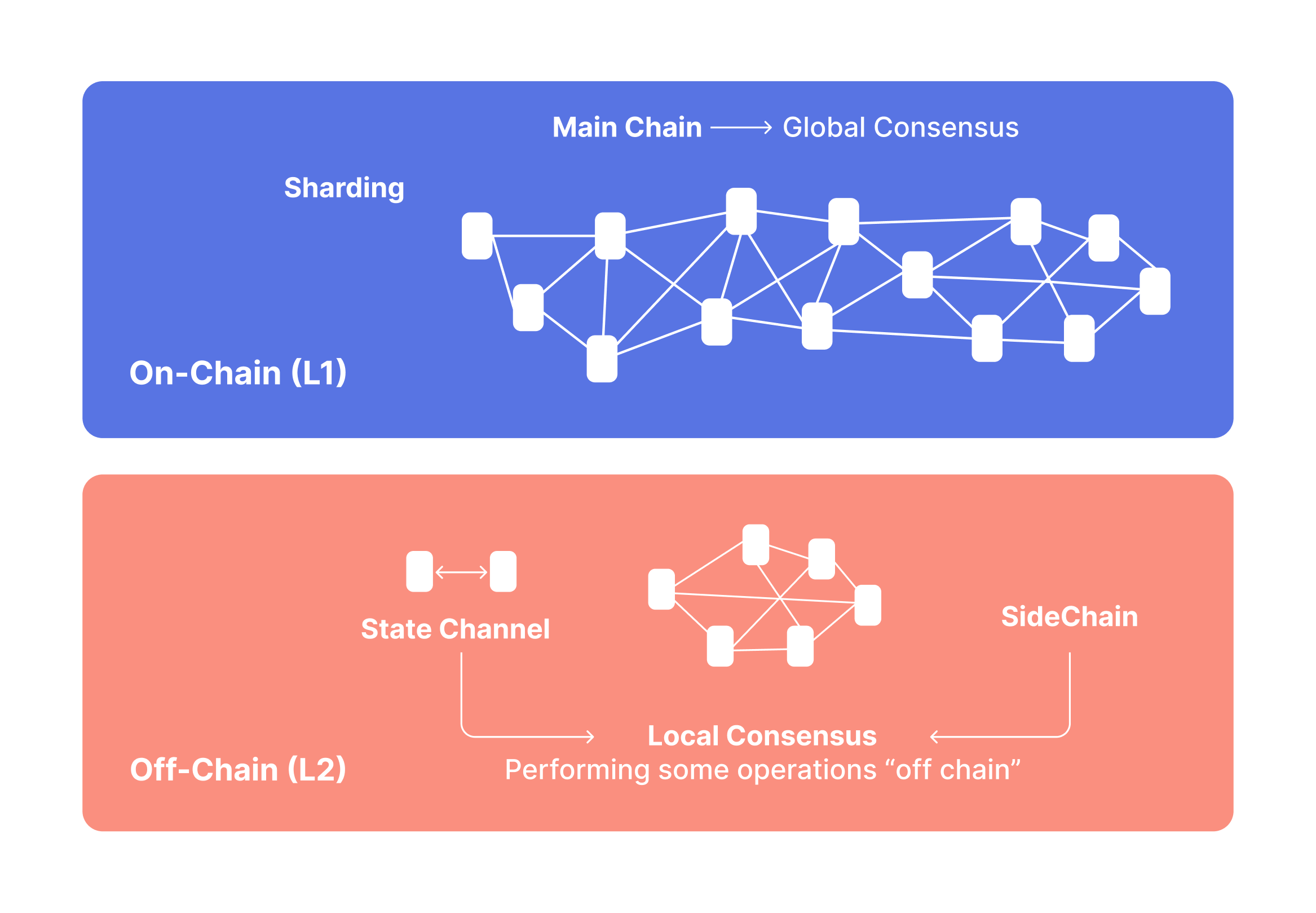

ステップ1: オンチェーンデータの基盤を構築する(ソース + 再現性)

実用的なオンチェーンワークフローには2つの層が必要です:生のチェーントゥルースと強化されたコンテキスト。

A. 生のチェーントゥルース(標準入力)

最低限、収集することを計画します:

プロのヒント: すべてのデータセットを バージョン管理されたスナップショット として扱います:

B. 補強(「意味」に必要なコンテキスト)

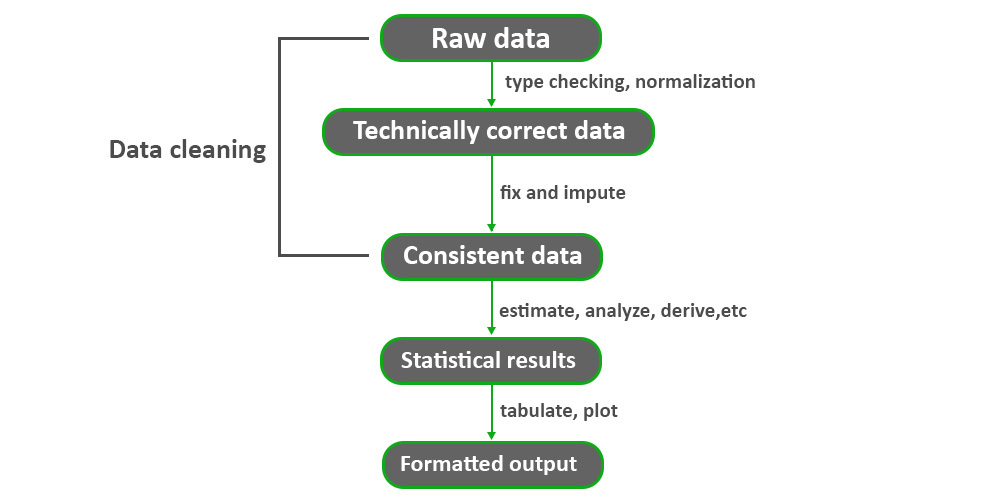

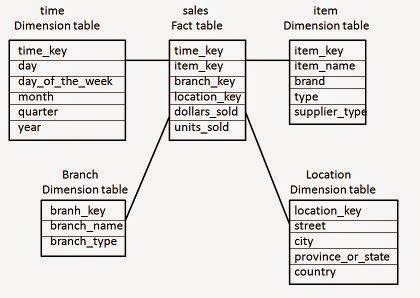

最小限の再現可能なスキーマ(データウェアハウスに必要なもの)

「ファクトテーブル」と「ディメンション」を考えます:

fact_swaps(chain, block_time, tx_hash, pool, token_in, token_out, amount_in, amount_out, trader, fee_paid)fact_borrows(chain, block_time, market, borrower, asset, amount, rate_mode, health_factor)dim_address(address, label, type, confidence, source)dim_token(token, decimals, is_wrapped, underlying, risk_flags)dim_pool(pool, protocol, pool_type, fee_tier, token0, token1)下流の機能が壊れないように inline code の命名を一貫して使用してください。

ステップ2: エンティティを正規化する(アドレス → アクター)

AIモデルは16進数の文字列で考えません; 彼らは 行動パターン から学びます。あなたの仕事は、可能な限りアドレスを安定した「エンティティ」に変換することです。

実用的なラベリングアプローチ(速い → より良い)

3つのティアから始めます:

各ラベルに保存するもの

label(例: “MEVボット”, “プロトコル財務”)confidence(0–1)evidence (トリガーされたルール、ヒューリスティック、リンク)valid_from / valid_to (ラベルが変更されます!)ウォレットクラスタリング:保守的に保つ

クラスタリングは役立ちます(例:1つのオペレーターによって制御されるアドレスのグループ化)が、間違っているとデータセットを汚染する可能性もあります。

| エンティティタスク | それがアンロックするもの | 一般的な落とし穴 |

|---|---|---|

| コントラクト分類 | プロトコルレベルの機能 | プロキシ/アップグレードパターンが誤解を招く |

| ウォレットクラスタリング | コホートフロー | 共有資金提供者からの誤ったマージ |

| ボット検出 | クリーンな「オーガニック」信号 | ボットが適応するにつれてラベルが漂流する |

| 財務省の特定 | 実際の利回り分析 | 財務省とユーザーフィーの混同 |

ステップ3:DeFiのための特徴エンジニアリング(「経済的真実」レイヤー)

ここがAIが役立つところです。モデルは特徴から学習します—したがって、メカニズムを反映する特徴を設計してください、「数値」だけではなく。

A. DEXおよび流動性の特徴(実行の現実)

役立つ特徴には以下が含まれます:

太字のルール: 取引可能性を気にするなら、ストレス下でのスリッページをモデル化し、「平均日次ボリューム」ではありません。

B. 貸付の特徴(支払不能と反射性)

C. “実質利回り” vs インセンティブ利回り(持続可能性の核心)

DeFiの利回りはしばしば混在します:

実用的な分解:

gross_yield = fee_yield + incentive_yieldreal_yield ≈ fee_yield - dilution_cost(ここで、希薄化コストは文脈依存ですが、少なくとも排出量を時価総額と流通供給の成長の割合として追跡する必要があります)重要な洞察: 持続可能な利回りは、最高の利回りであることは稀です。インセンティブが減少したときに生き残る利回りです。

ステップ4: 目標にラベルを付ける(モデルに予測させたいこと)

多くのDeFiデータセットは、ラベルが曖昧なため失敗します。良いターゲットは具体的で測定可能です。

モデルターゲットの例

ラベル漏れを避ける

ラベルが未来の情報(後の悪用など)を使用している場合、特徴量はイベント前に利用可能なデータのみを使用するようにしてください。そうでないと、モデルは「不正行為」をします。

ステップ 5: 正しいAIアプローチを選ぶ(LLMが適合する場所)

異なるDeFiの質問は異なるモデルファミリーにマッピングされます。

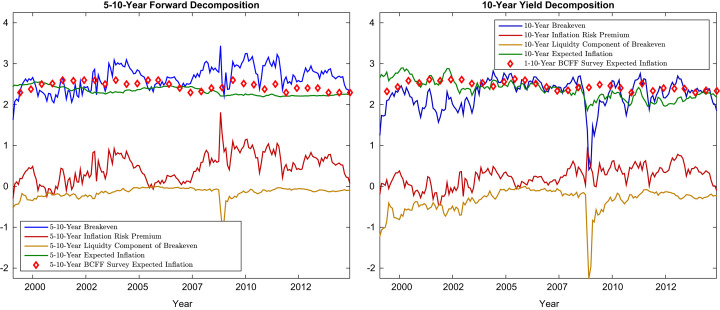

A. 時系列予測(ダイナミクスが重要な場合)

次のような予測を行うときに使用します:

B. 分類とランキング(「トップ候補」を選ぶとき)

次のような場合に必要です:

C. 異常検出(攻撃がまだわからないとき)

次のような場合に役立ちます:

D. グラフ学習(関係が信号であるとき)

オンチェーンは自然にグラフです:ウォレット ↔ コントラクト ↔ プール ↔ アセット。グラフベースの特徴は次のような場合にフラットテーブルを上回ることができます:

LLMが役立つ場所(役立たない場所)

LLMは次のことに優れています:

LLMは代替にはなりません:

実用的なハイブリッド:

ステップ 6: 評価とバックテスト(交渉不可の部分)

DeFiは非定常です。慎重に評価しないと、あなたの「信号」は蜃気楼です。

A. ランダムではなく時間で分割

時間ベースの分割を使用します:

B. 精度と意思決定の質の両方を追跡する

DeFiでは、単に「正確性」だけでなく、ランキングとリスクが重要です。

シンプルな評価チェックリスト

1. 意思決定ルールを定義する(例: 「リスクスコアが0.7を超えた場合は回避」)

2. 取引コストとスリッページの仮定でバックテストする

3. ストレスレジームを実行する(高ガス、高ボラティリティ、流動性クランチ)

4. ベースラインと比較する(シンプルなヒューリスティックがしばしば勝つ)

5. 監査トレイルを保存する(特徴、モデルバージョン、スナップショットブロック)

| 評価レイヤー | 測定する内容 | なぜ重要か |

|---|---|---|

| 予測的 | AUC / エラー | シグナルの質 |

| 経済的 | PnL / ドローダウン / スリッページ | 現実世界での実現可能性 |

| 操作的 | レイテンシ / 安定性 | 毎日実行できるか? |

| 安全性 | 偽陽性/偽陰性 | リスク許容度の整合性 |

ステップ7: ループとしてデプロイする(単発のレポートではない)

実際の「実用的なワークフロー」は、毎日/毎週実行できるループです。

コア生産ループ

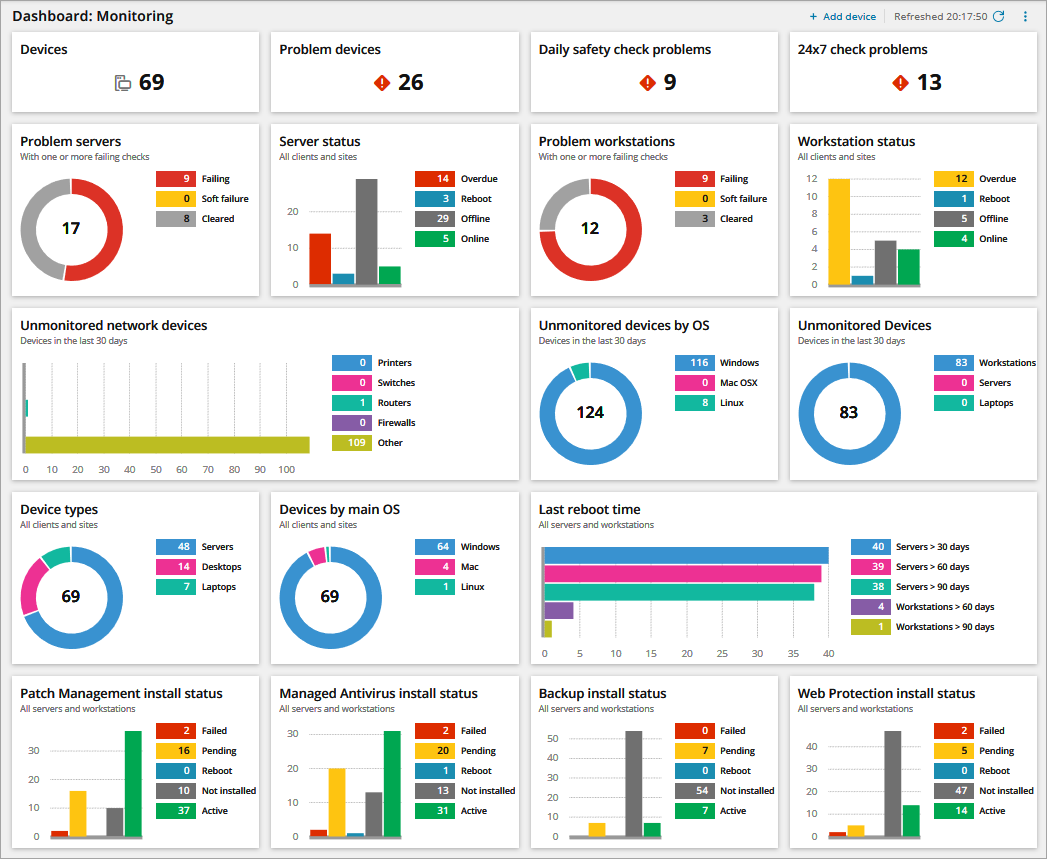

DeFiで重要なモニタリング

実用的なルール: モデルがスコアを変更した理由を説明できない場合、反射的な市場ではそれを信頼できません。

実例: “このAPYは本物ですか?”

一般的なDeFiの罠にワークフローを適用してみましょう: 主にインセンティブである魅力的な利回り。

ステップバイステップ

計算:

fee_revenue_usd (取引手数料 / 借入金利)incentives_usd (排出量 + 賄賂 + 報酬)net_inflows_usd (TVLはオーガニックか傭兵か?)user_return_estimate (手数料収入からIL / 借入コストを差し引いたもの)単純な持続可能性比率:

fee_to_incentive = fee_revenue_usd / max(incentives_usd, 1)解釈:

fee_to_incentive > 1.0 はしばしば手数料支援の利回りを示しますfee_to_incentive < 0.3 はインセンティブが支配していることを示唆します| 指標 | 何を示すか | レッドフラッグの閾値 |

|---|---|---|

| feetoincentive | 手数料支援 vs 排出量 | < 0.3 |

| TVLの変動 | 傭兵流動性 | 高い週次変動 |

| クジラのシェア | 集中リスク | 上位5 > 40% |

| MEVの強度 | 実行の毒性 | サンドイッチ率の上昇 |

| TVLあたりのネット手数料 | 効率 | 下降トレンド |

AIを追加:

fee_revenue_usdを予測

DeFiデータ分析のためのAIはオンチェーンでどのように機能しますか?

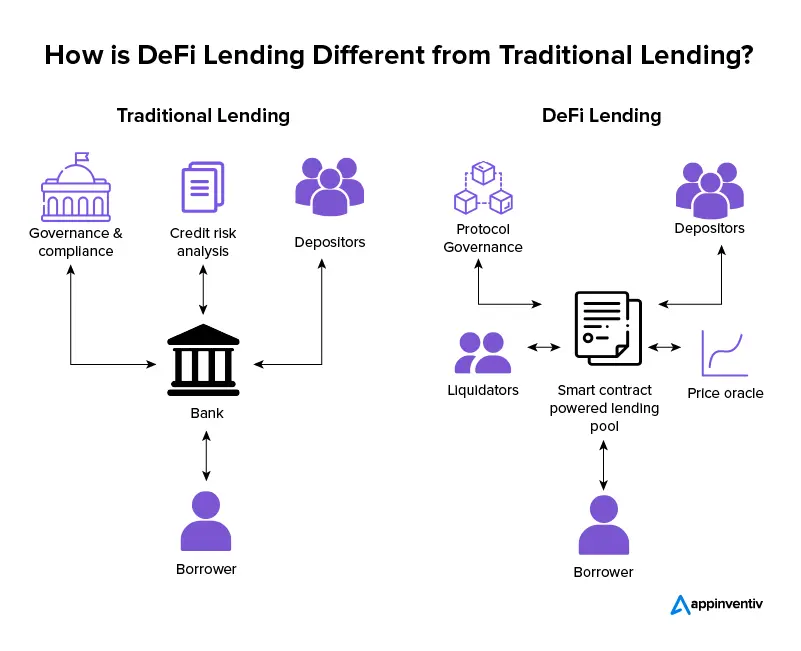

AIによるDeFiデータ分析は、低レベルのブロックチェーンアーティファクト(トランザクション、ログ、トレース、状態)を経済的特徴(手数料、レバレッジ、流動性の深さ、リスク集中)に変換し、測定可能な結果(利回りの持続可能性、流動性ショック、破産リスク、異常なフロー)を予測するパターンを学習します。「AI」部分は次のような要素に依存します:

ワークフローを繰り返し可能なシステムとして扱うと、SimianXスタイルの段階的研究アプローチのように、時間とともに改善されるモデルが得られ、脆弱な一回限りの洞察ではなくなります。

実用的なツール:実際に運用できる最小スタック

大規模なチームは必要ありませんが、規律が必要です。

A. データレイヤー

B. アナリティクスレイヤー

C. 「リサーチエージェント」レイヤー(オプションですが強力)

ここでマルチエージェントの考え方が光ります:

ここでもSimianX AIが役立つメンタルモデルとなります:単一の「全知の」分析に依存するのではなく、専門的な視点を使用し、明示的なトレードオフを強制します—その後、明確で構造化されたレポートを出力します。プラットフォームアプローチについてはSimianX AIで探ることができます。

一般的な失敗モード(およびそれを避ける方法)

DeFiデータ分析のためのAIに関するFAQ: 実践的なオンチェーンワークフロー

DeFiにおける機械学習のためのオンチェーン機能をどのように構築しますか?

プロトコルのメカニクスから始めます: イベントを経済(手数料、債務、担保、流動性の深さ)にマッピングします。ローリングウィンドウを使用し、リークを避け、結果を再現できるようにバージョン管理された特徴定義を保存してください。

DeFiにおける実際の利回りとは何であり、なぜ重要ですか?

実際の利回りは、トークンの排出ではなく、主にオーガニックなプロトコル収益(手数料/利息)によって裏付けられた利回りです。排出は消える可能性がある一方で、手数料に裏付けられたリターンはしばしば持続します(ただし、依然として周期的である可能性があります)。

自分を欺かずにDeFiシグナルをバックテストする最良の方法は何ですか?

時間で分割し、取引コストとスリッページを含め、ストレスレジーム全体でテストします。常にシンプルなベースラインと比較してください; あなたのモデルがヒューリスティックに確実に勝てない場合、それはおそらく過剰適合しています。

LLMは量的オンチェーン分析を置き換えることができますか?

LLMは解釈を迅速化できます—提案を要約し、仮定を抽出し、チェックリストを整理しますが、正しいイベントのデコード、厳密なラベリング、時間ベースの評価を置き換えることはできません。LLMを使用して研究を構造化し、「幻覚」を引き起こすためにチェーンを使用しないでください。

インセンティブ駆動(傭兵的)流動性をどのように検出しますか?

TVLの流出、インセンティブ対手数料の比率、ウォレットコホートの構成を追跡します。インセンティブが急増したときに流動性が現れ、その後すぐに離脱する場合は、手数料が独立してそれを支えない限り、利回りを脆弱なものとして扱います。

結論

AIは、オンチェーンのノイズを繰り返し可能なワークフローに変換することで、DeFiにおいて真に価値を持ちます:意思決定優先のフレーミング、再現可能なデータセット、保守的なエンティティラベリング、メカニズムベースの特徴、時間分割評価、そして継続的なモニタリング。この実用的なオンチェーンループに従うことで、プロトコル間で比較可能で、体制の変化に対して強靭で、チームメイトやステークホルダーに説明可能な分析を生み出すことができます。

段階的で多角的な研究を実施するための構造化された方法を探している場合(複雑なデータを明確で共有可能な出力に変換するため)、厳密な分析を実行可能なワークフローに整理するモデルとしてSimianX AIを検討してください。