A Segurança das Criptomoedas Baseadas em Inteligência Artificial

A segurança das criptomoedas baseadas em inteligência artificial não se resume mais apenas a contratos inteligentes e chaves privadas. Quando um token, protocolo ou “produto cripto” depende de modelos de IA—previsão de preços, pontuação de risco, criação de mercado automatizada, lógica de liquidação, detecção de fraude ou agentes autônomos—você herda dois universos de segurança ao mesmo tempo: segurança de blockchain e segurança de IA/ML. A parte difícil é que esses universos falham de formas diferentes: blockchains falham de forma ruidosa (explorações on-chain), enquanto sistemas de IA frequentemente falham silenciosamente (decisões ruins que parecem “plausíveis”). Neste guia, construiremos um modelo de ameaça prático e um plano de defesa que você pode aplicar—além de mostrar como um fluxo de trabalho estruturado de pesquisa (por exemplo, usando SimianX AI) ajuda a validar suposições e reduzir pontos cegos.

O que conta como uma “criptomoeda baseada em IA”?

“Criptomoeda baseada em IA” é usado de forma ampla online, então a análise de segurança começa com uma definição clara. Na prática, os projetos geralmente se enquadram em uma (ou mais) das seguintes categorias:

1. IA no protocolo: a IA influencia diretamente a lógica on-chain (por exemplo, atualizações de parâmetros, taxas dinâmicas, limites de risco, fatores de colateral).

2. IA como oráculo: um modelo off-chain produz sinais que alimentam contratos (por exemplo, volatilidade, pontuações de fraude, níveis de risco).

3. Agentes de IA como operadores: bots autônomos gerenciam tesouraria, executam estratégias ou operam keepers/liquidações.

4. Ecossistemas de tokens de IA: o token incentiva dados, computação, treinamento de modelos, marketplaces de inferência ou redes de agentes.

5. Tokens com marca de IA (focados em marketing): dependência mínima de IA; o risco é principalmente governança, liquidez e contratos inteligentes.

Resumo de segurança: quanto mais as saídas de IA afetam a transferência de valor (liquidações, mint/burn, colateral, movimentações do tesouro), mais você deve tratar o pipeline de IA como infraestrutura crítica, e não apenas “análise”.

No momento em que a saída de um modelo pode desencadear mudanças de estado on-chain, a integridade do modelo se torna integridade financeira.

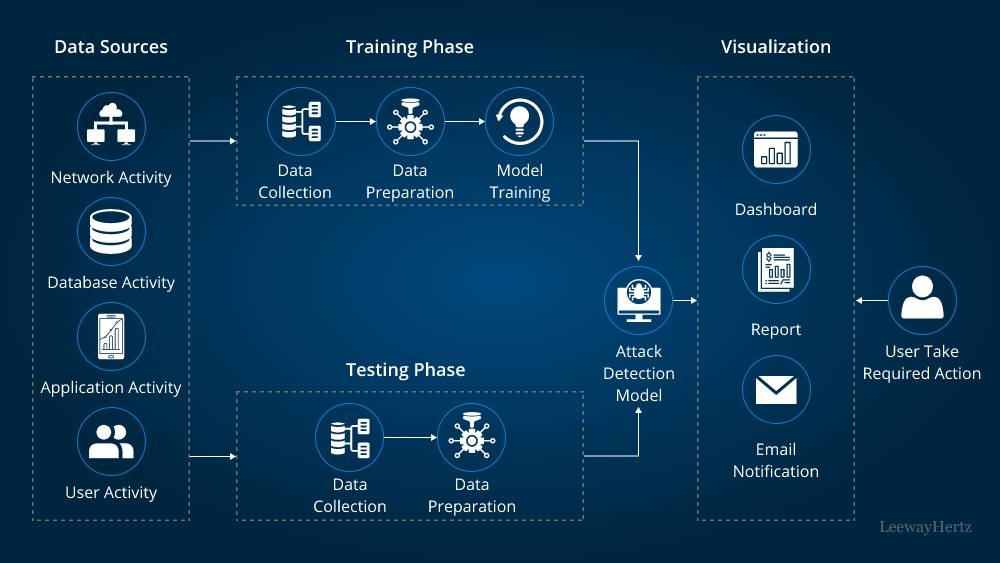

Um modelo de ameaça em camadas para segurança cripto baseada em IA

Um framework útil é tratar sistemas cripto baseados em IA como cinco camadas interligadas. Você quer controles em cada camada porque os atacantes exploram a mais fraca.

| Camada | O que inclui | Modo típico de falha | Por que é único em cripto baseado em IA |

|---|---|---|---|

| L1: Código on-chain | contratos, upgrades, controle de acesso | bug explorável, abuso administrativo | a transferência de valor é irreversível |

| L2: Oráculos & dados | feeds de preço, eventos on-chain, APIs off-chain | entradas manipuladas | IA depende da qualidade dos dados |

| L3: Modelo & treinamento | conjuntos de dados, rótulos, pipeline de treinamento | envenenamento, backdoors | modelo pode parecer “correto” mas estar errado |

| L4: Inferência & agentes | endpoints, ferramentas de agentes, permissões | injeção de prompt, abuso de ferramentas | “decisões” do agente podem ser coagidas |

| L5: Governança & operações | chaves, multisig, monitoramento, resposta a incidentes | reação lenta, controles fracos | a maioria das “falhas de IA” são operacionais |

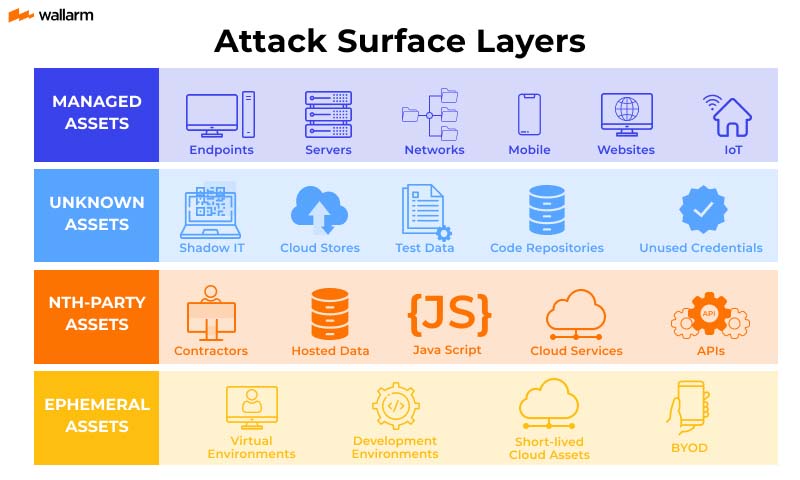

Principais riscos de segurança (e o que torna cripto baseada em IA diferente)

1) Vulnerabilidades de smart contracts ainda dominam—IA pode ampliar o raio de impacto

Problemas clássicos (reentrância, erros de controle de acesso, bugs em upgrades, manipulação de oráculos, precisão/arredondamento, exposição a MEV) continuam sendo #1. A diferença com IA é que a automação conduzida por IA pode acionar essas falhas mais rapidamente e com mais frequência, especialmente quando agentes operam 24/7.

Defesas

2) Manipulação de oráculos e dados—agora com “envenenamento amigável à IA”

Os atacantes nem sempre precisam quebrar a cadeia; eles podem manipular os inputs do modelo:

Isso é envenenamento de dados, e é perigoso porque o modelo pode continuar a passar em métricas normais enquanto aprende silenciosamente comportamentos escolhidos pelo atacante.

Defesas

Se você não pode provar de onde vieram os inputs do modelo, você não pode provar por que o protocolo se comporta da forma que se comporta.

3) Ataques de ML adversariais—evasão, backdoors e extração de modelo

Modelos de IA podem ser atacados de maneiras que não parecem “hacks” tradicionais:

Defesas

limitação de taxa, autenticação, detecção de anomalias, orçamentos de consultas.4) Injeção de prompt e abuso de ferramentas em agentes de IA

Se agentes podem chamar ferramentas (negociar, transferir, assinar, postar governança, atualizar parâmetros), eles podem ser atacados via:

Defesas

5) Governança & segurança operacional—ainda o caminho mais fácil de invasão

Mesmo o melhor código e modelos falham se:

Defesas

Quão seguras são, realmente, as criptomoedas baseadas em inteligência artificial?

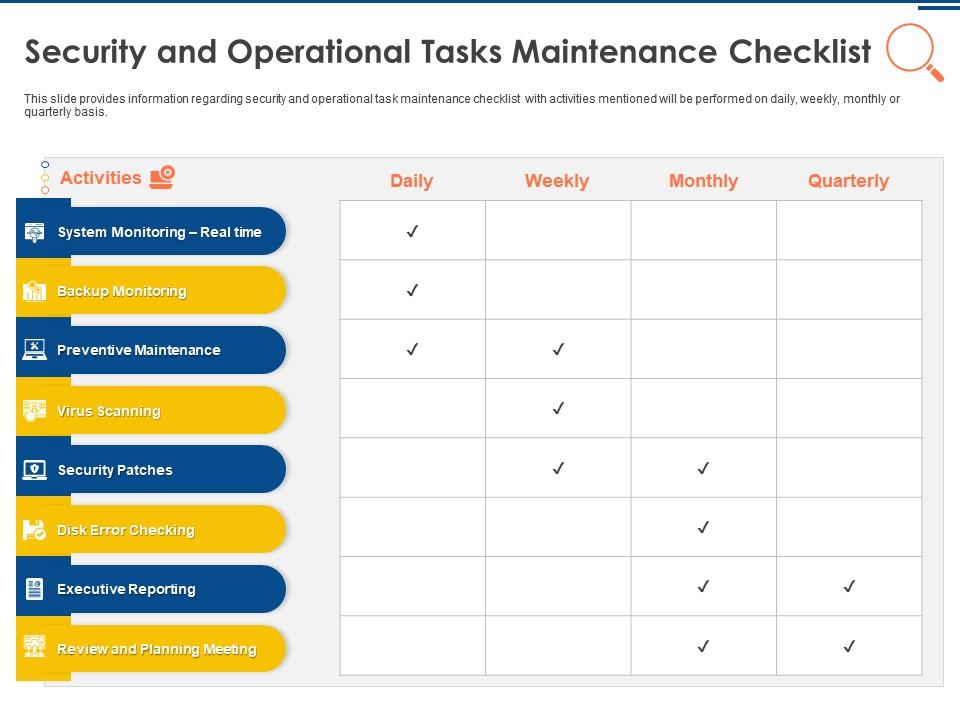

Um roteiro prático de avaliação (para desenvolvedores + investidores)

Use esta lista de verificação para avaliar projetos reais. Você não precisa de respostas perfeitas—precisa de evidências falsificáveis.

A. Controles on-chain (essenciais)

B. Integridade de dados e oráculos (crítico para IA)

C. Governança do modelo (específica de IA)

D. Segurança de agentes (se agentes executarem ações)

E. Segurança econômica e de incentivos

Um método simples de pontuação

Atribua 0–2 pontos por categoria (0 = desconhecido/inseguro, 1 = parcial, 2 = evidência forte). Um projeto com pontuação <6/10 deve ser tratado como “experimental”, independentemente do marketing.

1. Controles on-chain (0–2)

2. Dados/oráculos (0–2)

3. Governança do modelo (0–2)

4. Segurança de agentes (0–2)

5. Incentivos/economia (0–2)

Padrões de arquitetura defensiva que realmente funcionam

Aqui estão padrões usados em sistemas de alta segurança, adaptados para cripto baseada em IA:

Padrão 1: “IA sugere, regras determinísticas decidem”

Deixe o modelo propor parâmetros (níveis de risco, alterações de taxa), mas imponha mudanças com restrições determinísticas:

p > limiar)Por que funciona: mesmo se o modelo estiver errado, o protocolo falha graciosamente.

Padrão 2: Consenso multi-fonte, multi-modelo

Ao invés de depender de um modelo, use verificações em conjunto:

Então exija consenso (ou que o “score de discordância” esteja abaixo de um limite).

Por que funciona: envenenar um caminho fica mais difícil.

Padrão 3: Cadeia de suprimento de dados segura

Trate conjuntos de dados como código:

Por que funciona: a maioria dos ataques de IA são ataques a dados.

Padrão 4: Particionamento de permissões de agentes

Separe:

Por que funciona: injeção de prompt se torna menos fatal.

Passo a passo: Como auditar um projeto cripto baseado em IA (rápido, mas sério)

1. Mapear caminhos de transferência de valor

2. Identificar dependências de IA

3. Rastrear o pipeline de dados

4. Testar manipulação

5. Revisar governança do modelo

6. Inspecionar permissões do agente

7. Validar monitoramento e resposta

8. Avaliar incentivos

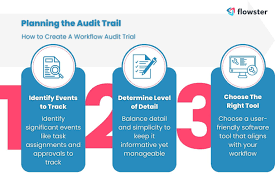

Dica profissional: Um fluxo de trabalho de pesquisa estruturado ajuda a evitar perder conexões entre as camadas. Por exemplo, a análise multiagente no estilo SimianX AI pode ser usada para separar suposições, realizar verificações cruzadas e manter um “rastro de decisão” auditável ao avaliar sistemas criptográficos movidos por IA — especialmente quando narrativas e dados mudam rapidamente.

Sinais vermelhos comuns de “teatro de segurança” em criptomoedas baseadas em IA

Fique atento a esses padrões:

Segurança não é uma lista de recursos. É a evidência de que um sistema falha de forma segura quando o mundo se comporta de forma adversarial.

Ferramentas práticas e fluxos de trabalho (onde o SimianX AI se encaixa)

Mesmo com controles técnicos sólidos, investidores e equipes ainda precisam de maneiras repetíveis de avaliar riscos. Um bom fluxo de trabalho deve:

Você pode usar o SimianX AI como uma estrutura prática para organizar esse processo—especialmente organizando perguntas em risco, integridade dos dados, governança do modelo e restrições de execução, e produzindo notas de pesquisa consistentes. Se você publicar conteúdo para sua comunidade, vincular pesquisas de apoio ajuda os usuários a tomar decisões mais seguras (veja o hub de histórias de fluxo de trabalho de criptomoeda do SimianX para exemplos de abordagens de análise estruturada).

Perguntas Frequentes Sobre a segurança das criptomoedas baseadas em inteligência artificial

Qual é o maior risco de segurança nas criptomoedas baseadas em IA?

A maioria das falhas ainda vem de segurança de contratos inteligentes e operacional, mas a IA adiciona um segundo modo de falha: dados manipulados que causam decisões “válidas”, mas prejudiciais. Você precisa de controles para ambas as camadas.

Como posso saber se um projeto de token AI está realmente usando IA de forma segura?

Procure evidências: versionamento de modelos, proveniência de dados, testes adversariais e modos de falha claros (o que acontece quando os dados estão ausentes ou a confiança é baixa). Se nenhum desses estiver documentado, trate "IA" como marketing.

Como auditar projetos de criptomoeda baseados em IA sem ler milhares de linhas de código?

Comece com um modelo de ameaça em camadas: controles on-chain, dados/oráculos, governança de modelos e permissões de agentes. Se você não conseguir mapear como as saídas de IA influenciam a transferência de valor, não poderá avaliar o risco.

Agentes de negociação de IA são seguros para operar nos mercados de criptomoedas?

Podem ser, mas apenas com privilégio mínimo, ações permitidas, limites de taxa e aprovações humanas para ações de alto impacto. Nunca dê a um agente autoridade irrestrita para assinar.

A descentralização torna a IA mais segura em criptomoedas?

Não automaticamente. A descentralização pode reduzir pontos únicos de falha, mas também pode criar novas superfícies de ataque (contribuidores maliciosos, mercados de dados envenenados, explorações de incentivos). A segurança depende de governança e incentivos.

Conclusão

A segurança das criptomoedas baseadas em IA exige uma mentalidade mais ampla do que auditorias tradicionais de cripto: você deve proteger código, dados, modelos, agentes e governança como um único sistema. Os melhores designs assumem que os inputs são adversariais, limitam os danos de saídas incorretas do modelo e exigem evidências reproduzíveis—não intuições. Se você quer uma maneira repetível de avaliar projetos de cripto movidos por IA, construa um fluxo de trabalho baseado em checklist e mantenha um registro claro de decisões. Você pode explorar abordagens de análise estruturada e ferramentas de pesquisa em SimianX AI para tornar suas revisões de segurança de IA-cripto mais consistentes e defensáveis.