人工智能 vs 人工密码学:时间与准确性的比较

如果你搜索 “人工智能 vs 人工密码学 时间与准确性比较”,你会很快注意到一件事:人们使用相同的词——时间 和 准确性——却指代完全不同的含义。在 AI 中,“准确性”通常指数据集上的百分比得分。而在密码学中,“准确性”更接近 正确性(加密/解密是否总是有效?)和 安全性(在现实假设下,攻击者能否破解?)。混用这些定义会导致错误的结论,更糟糕的是,会导致糟糕的系统。

这篇研究风格的指南为你提供了一种实用方法,用共享的语言比较 人工智能(AI) 与 人工密码学(我们将其定义为 人类设计的密码构造和受密码学启发的基准任务):可测量的时间成本、可测量的误差以及可测量的风险。我们还将展示如何通过结构化的研究工作流程——类似你可以在 SimianX AI 中记录和操作的流程——帮助你避免“快但错”的结果。

首先:我们所说的“人工密码学”是什么意思?

“人工密码学”这一短语并不是标准教科书中的分类,因此我们将在本文中明确其定义,以避免混淆:

这很重要,因为“赢家”取决于你比较的内容:

核心错误是将 AI 的 平均情况准确率 与密码学的 最坏情况安全目标 进行比较。它们的目标不同。

时间和准确性不是单一数字

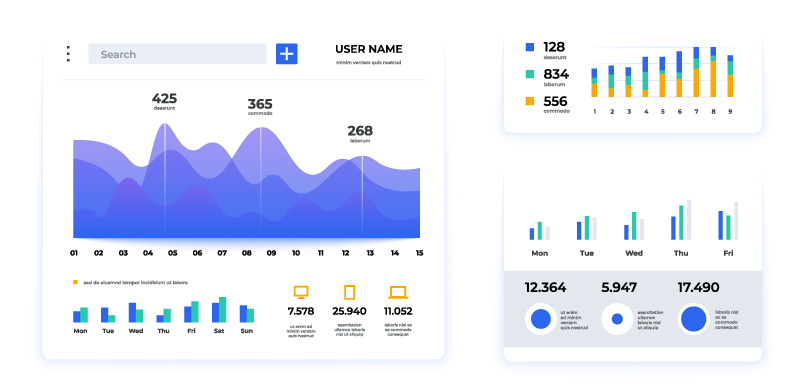

为了使比较公平,应将“时间”和“准确性”视为 一系列指标,而不是单一分数。

时间:你使用的是什么时钟?

以下是四个经常混淆的“时间”指标:

准确性:你需要哪种正确性?

在 AI 中,准确性通常意味着“预测与标签匹配的频率”。在密码学中,正确性和安全性有不同的定义:

共享比较表

| 维度 | AI 系统(典型) | 密码系统(典型) | 你在研究中需要测量的内容 |

|---|---|---|---|

| 目标 | 优化数据上的性能 | 抵御对手,保证特性 | 定义威胁模型和任务 |

| “准确性” | accuracy,F1,校准 | 正确性 + 安全裕度 | 错误率 + 攻击成功率 |

| 时间关注点 | T_train + T_infer | T_build + T_audit | 端到端决策时间 |

| 失败模式 | 自信但错误的答案 | 在攻击下灾难性崩溃 | 最坏情况影响 + 发生概率 |

| 可解释性 | 可选但有价值 | 通常必需(证明/规范) | 审计轨迹 + 可重复性 |

![table visualization placeholder]()

AI 在时间上倾向于获胜的地方

AI 往往在 分析任务 的 T_infer 和 工作流自动化 的 T_build 上占优势——这并非因为它保证真理,而是因为它压缩了劳动量:

在安全工作中,AI 最大的时间优势通常是 覆盖率:它可以在相同的实际时间内“阅读”或扫描远超过人类团队的内容,然后生成候选线索。

但 速度不等于安全。如果你在没有验证的情况下接受输出,你就是用时间换取风险。

实用规则

如果出错成本很高,你的工作流必须设计包含 T_audit——而不是事后补救。

密码学在准确性上倾向于获胜的地方(以及为什么这是一个不同的词)

密码学的设计特点是:

这种框架改变了“准确性”的含义。你不再问:

你要问的是:

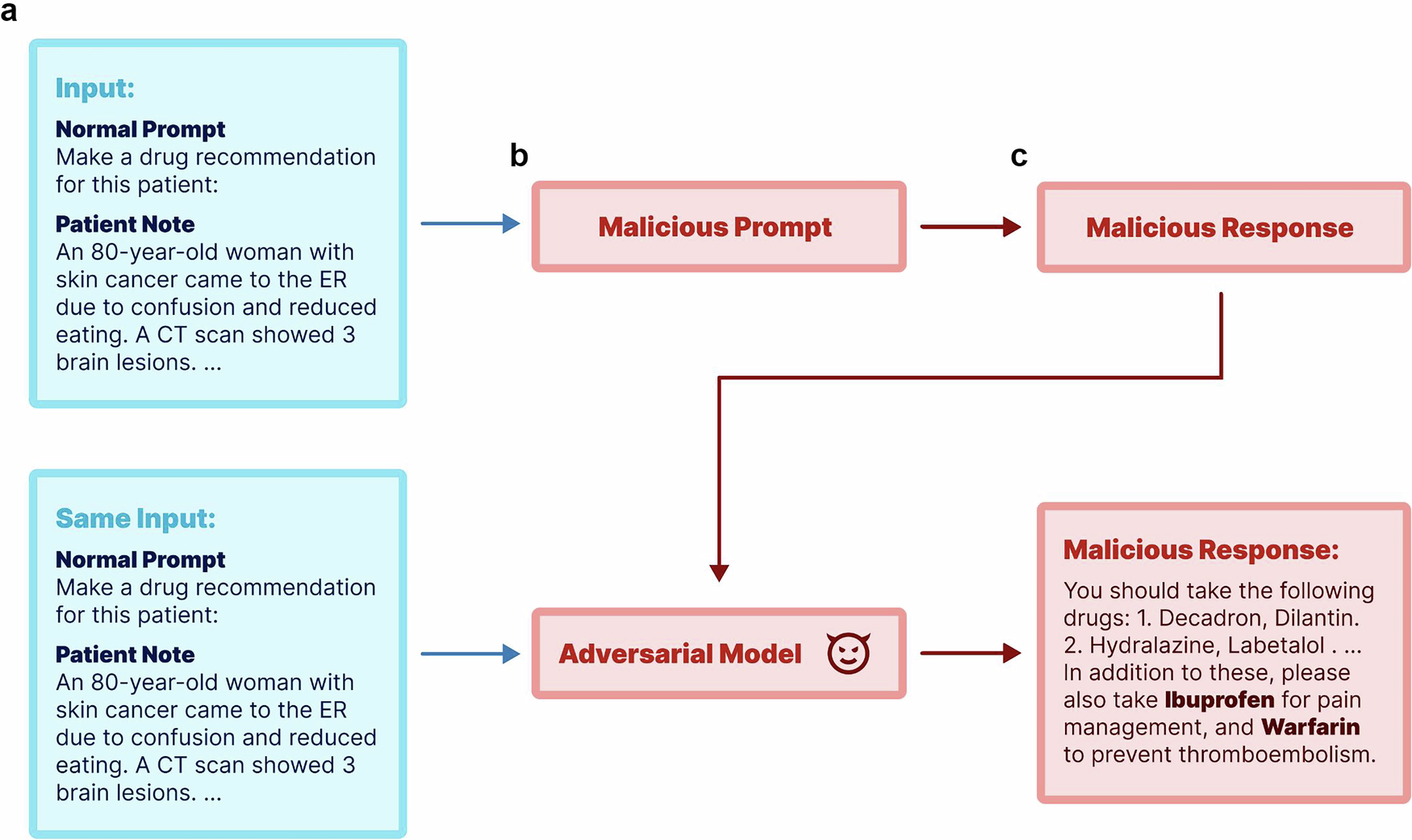

这是两个不同的问题。在许多现实场景中,AI 可以达到很高的预测准确率,但在对抗压力下(提示注入、数据投毒、分布偏移、成员推断等)仍然可能不安全。

所以密码学中的“准确率”更接近于“在攻击下的可靠性”。

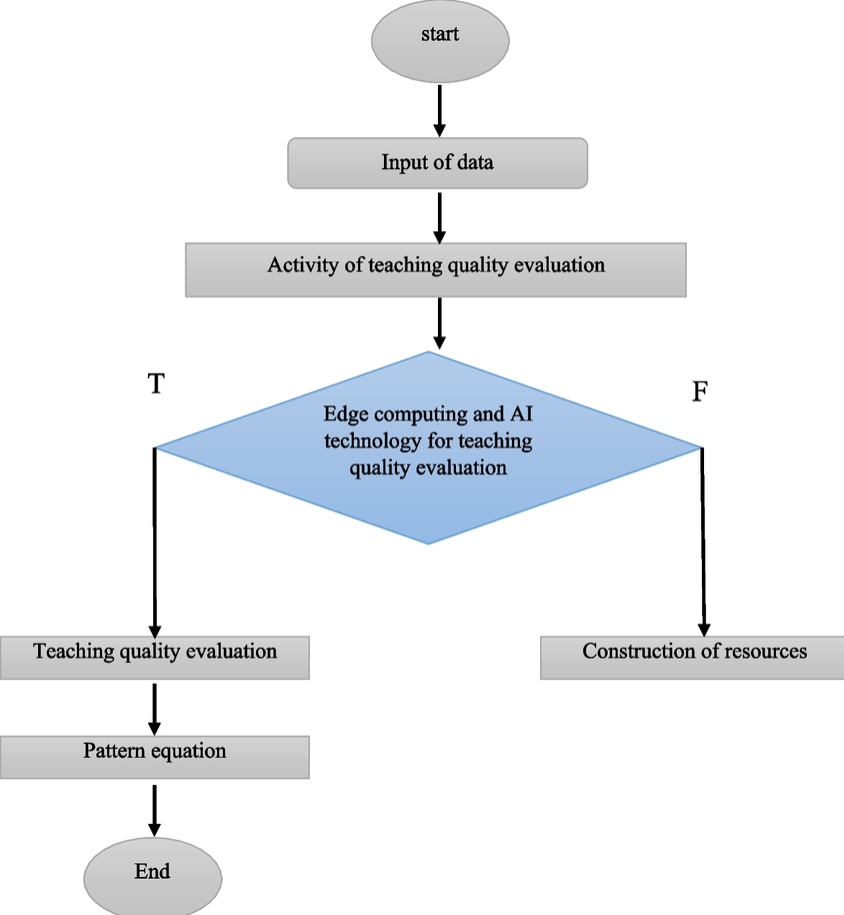

如何进行人工智能与人工密码学的时间与准确率比较?

要诚实地比较 AI 和人工密码学,你需要一个 基准协议——而不是凭感觉的争论。无论你是在研究安全系统还是加密市场基础设施,都可以应用以下工作流程。

第 1 步:定义任务(及其风险)

写一句话的任务定义:

然后标记风险等级:

第 2 步:定义威胁模型

至少需要指定:

第 3 步:选择与威胁模型匹配的指标

使用 AI 与密码学风格的指标混合:

accuracy、precision/recall、F1、校准误差T_build、T_train、T_infer、T_audit第4步:运行苹果对苹果基准测试

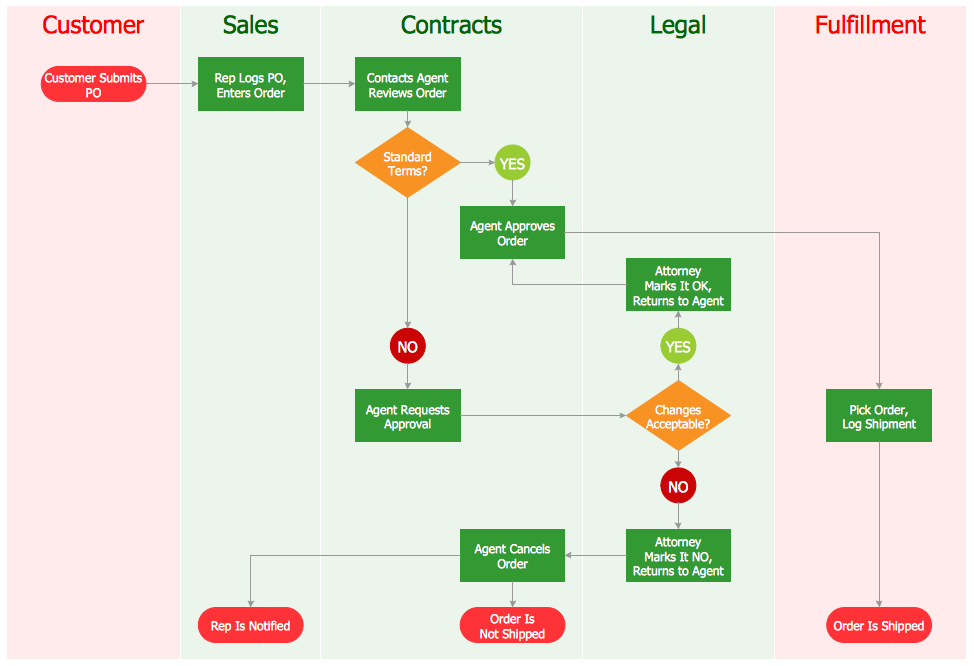

至少三个基准:

1. 经典加密/规则基准(规格驱动,确定性检查)

2. AI基准(在扩展复杂度之前的简单模型)

3. 混合基准(AI提议,加密验证)

第5步:将结果报告为权衡前沿

避免只报告一个“赢家”。报告一个前沿:

一个可信的研究不会推选冠军;它映射出权衡,让工程师可以根据风险选择。

第6步:使其可复现

这是许多比较失败的地方。保持:

这也是那些鼓励结构化决策记录(例如,多步骤研究笔记、检查清单、可追溯的输出)的工具能派上用场的地方。许多团队使用像SimianX AI这样的平台来标准化分析的文档记录、挑战和总结——即使是在投资环境之外。

一个现实的解释:AI作为速度层,加密学作为正确性层

在生产安全中,最有用的比较不是“AI与加密学”,而是:

实际中混合模式的表现

这种混合框架通常在时间和准确性上都能获胜,因为它尊重每种范式的优势。

决定“仅AI” vs “仅加密” vs “混合”的快速检查清单

你可以复制的迷你“研究设计”示例

以下是一个实用模板,用于在1-2周内进行比较:

F1(分流质量)T_infer(推理延迟)T_audit(解释失败所需时间)使用简单、一致的报告格式,使利益相关者能够随着时间推移进行比较。如果你的组织已经依赖于结构化的研究报告(或者你使用 SimianX AI 来保持一致的决策路径),可以重复使用相同的模式:假设 → 证据 → 裁决 → 风险 → 下一个测试。

关于人工智能与人工加密时间和准确性比较的常见问题

在AI与加密比较中,最大的错误是什么?

比较 平均情况模型准确性 与 最坏情况安全保证。AI 的得分可能看起来很高,但在面对对抗性压力或分布偏移时仍可能失败。

如何衡量类似密码学任务的“准确性”?

将任务定义为一个游戏:对攻击者或分类器而言,“成功”意味着什么?然后衡量错误率,以及(在相关情况下)攻击者相对于随机机会的优势——同时观察在对抗条件下结果的变化。

AI 对密码学有用,还是仅对密码分析有用?

AI 可以在许多辅助角色中发挥作用——测试、异常检测、实现审查辅助和工作流程自动化。最安全的模式通常是 AI 提出建议 并由 确定性检查进行验证。

如果训练需要几天而推理只需毫秒,如何公平比较时间?

报告多个时间指标:分别记录 T_train 和 T_infer,以及整个工作流程的端到端 决策时间。哪个系统“最好”取决于你是只支付一次训练成本还是需要重复训练。

高风险安全系统的良好默认方法是什么?

从密码学原语和核心保证的确定性控制开始,然后在不扩大攻击面前提下添加 AI 来降低操作负担——即采用 混合工作流程。

结论

有意义的 人工智能与人工密码学的时间和准确性比较 并不是为了宣告赢家,而是为了为正确的工作选择合适的工具。AI 在速度、覆盖范围和自动化方面往往占优;密码学在确定性正确性和对抗性保证方面占优。在高风险环境中,最有效的方法通常是混合型:AI 用于快速分类和探索,密码学用于验证和执行。

如果你想将这种比较操作化为可重复的工作流程——明确的决策框架、一致的指标、可审计的报告以及快速迭代——可以探索 SimianX AI 来帮助你从问题到决策结构化和记录你的分析。