AI para sa Pagsusuri ng Data ng DeFi: Isang Praktikal na On-Chain na Workflow

AI para sa Pagsusuri ng Data ng DeFi: Isang Praktikal na On-Chain na Workflow ay tungkol sa pag-convert ng transparent-ngunit-magulong aktibidad sa blockchain sa maulit-ulit na pananaliksik: malinis na datasets, mapagtanggol na mga tampok, nasusuring mga hypothesis, at minomonitor na mga modelo. Kung ikaw ay kailanman tumingin sa mga dashboard ng TVL, mga pahina ng yield, at mga chart ng token at naisip “ito ay parang hindi tiyak,” ang workflow na ito ang iyong lunas. At kung gusto mo ang nakabalangkas, nakasalang na pagsusuri (ang paraan ng SimianX AI sa pag-frame ng multi-step na mga loop ng pananaliksik), maaari mong dalhin ang parehong disiplina sa on-chain na trabaho upang ang mga resulta ay maipaliwanag, maihahambing sa iba’t ibang protocol, at madaling ulitin.

Bakit mas mahirap (at mas mabuti) ang pagsusuri ng on-chain na data kaysa sa hitsura nito

Ang on-chain na data ay nagbibigay sa iyo ng ground truth para sa mga nangyari: mga transfer, swap, utang, liquidation, staking, mga boto sa pamamahala, at daloy ng bayad. Ngunit ang “ground truth” ay hindi nangangahulugang “madaling katotohanan.” Ang mga analyst ng DeFi ay nakakaranas ng mga problema tulad ng:

Ang upside ay napakalaki: kapag nag-build ka ng AI-ready na pipeline, maaari mong sagutin ang mga tanong gamit ang ebidensya, hindi vibes—pagkatapos ay patuloy na i-run ang parehong workflow habang nagbabago ang mga kondisyon.

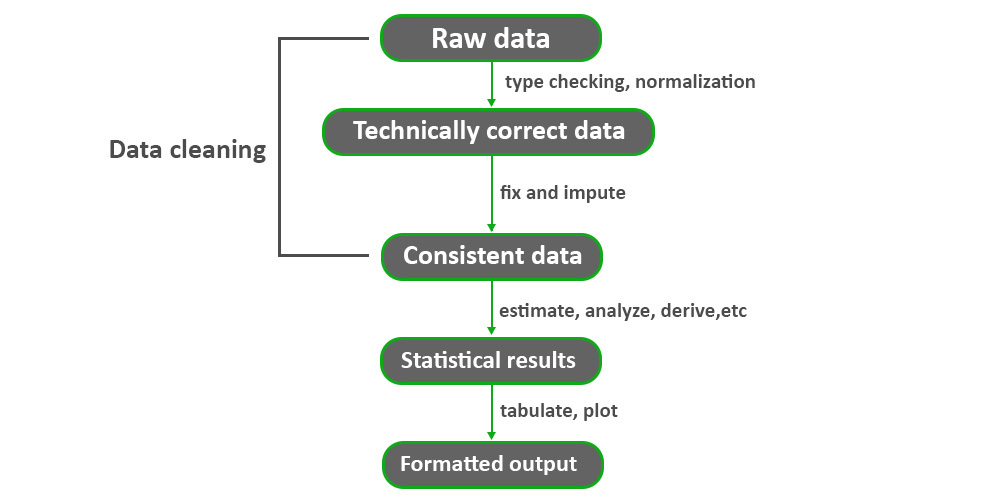

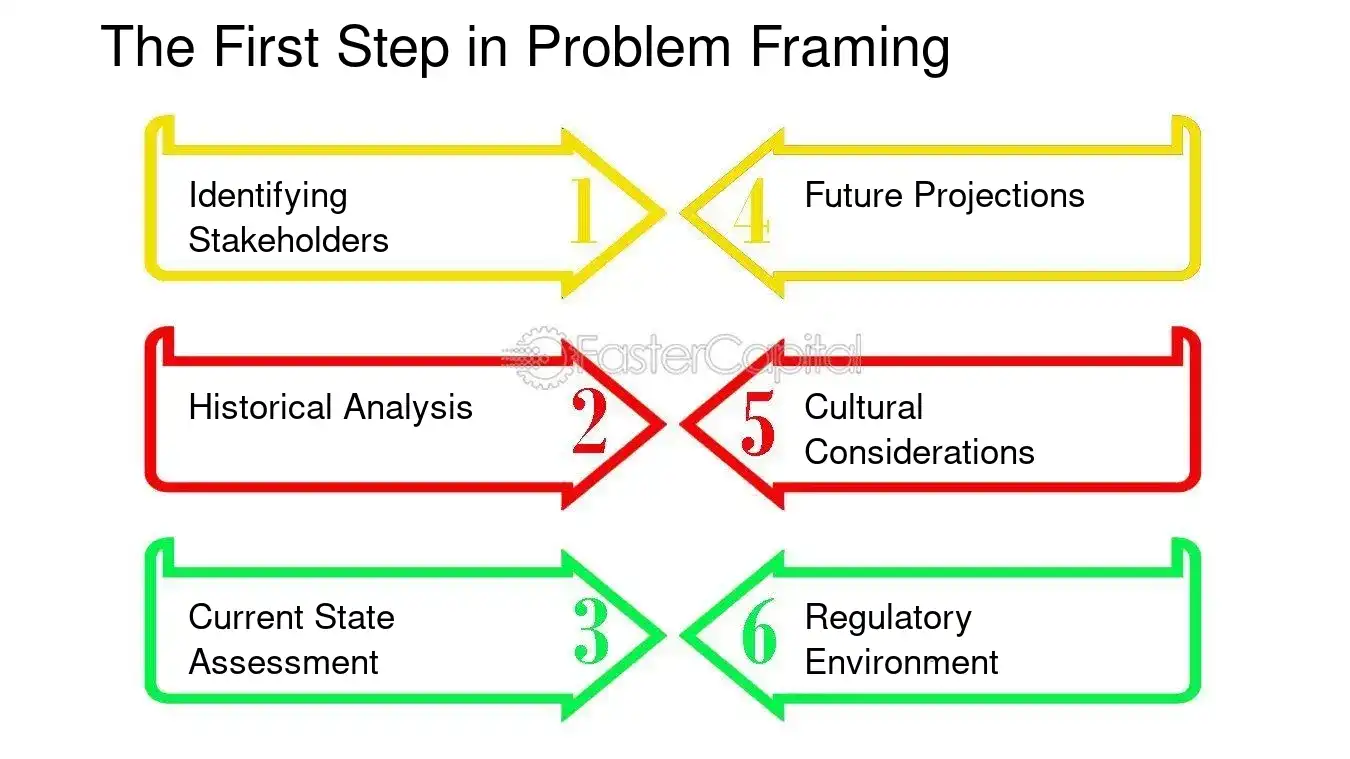

Hakbang 0: Magsimula sa isang desisyon, hindi sa isang dataset

Ang pinakamabilis na paraan upang masayang ang oras sa DeFi ay ang “i-download ang lahat” at umaasa na lalabas ang mga pattern. Sa halip, tukuyin:

1. Desisyon: ano ang gagawin mong iba batay sa pagsusuri?

2. Obheto: protocol, pool, token, estratehiya ng vault, o cohort ng wallet?

3. Horizon ng oras: intraday, lingguhan, quarterly?

4. Sukatan ng kinalabasan: ano ang itinuturing na tagumpay o kabiguan?

Mga halimbawa ng desisyon na mahusay na umaangkop sa AI

Pangunahing pananaw: Pinakamalakas ang AI kapag ang target ay nasusukat (hal., posibilidad ng drawdown, dalas ng liquidation, ratio ng bayarin sa emissions), hindi kapag ang target ay “mabuting naratibo.”

Hakbang 1: Itayo ang iyong pundasyon ng on-chain data (mga pinagmulan + reproducibility)

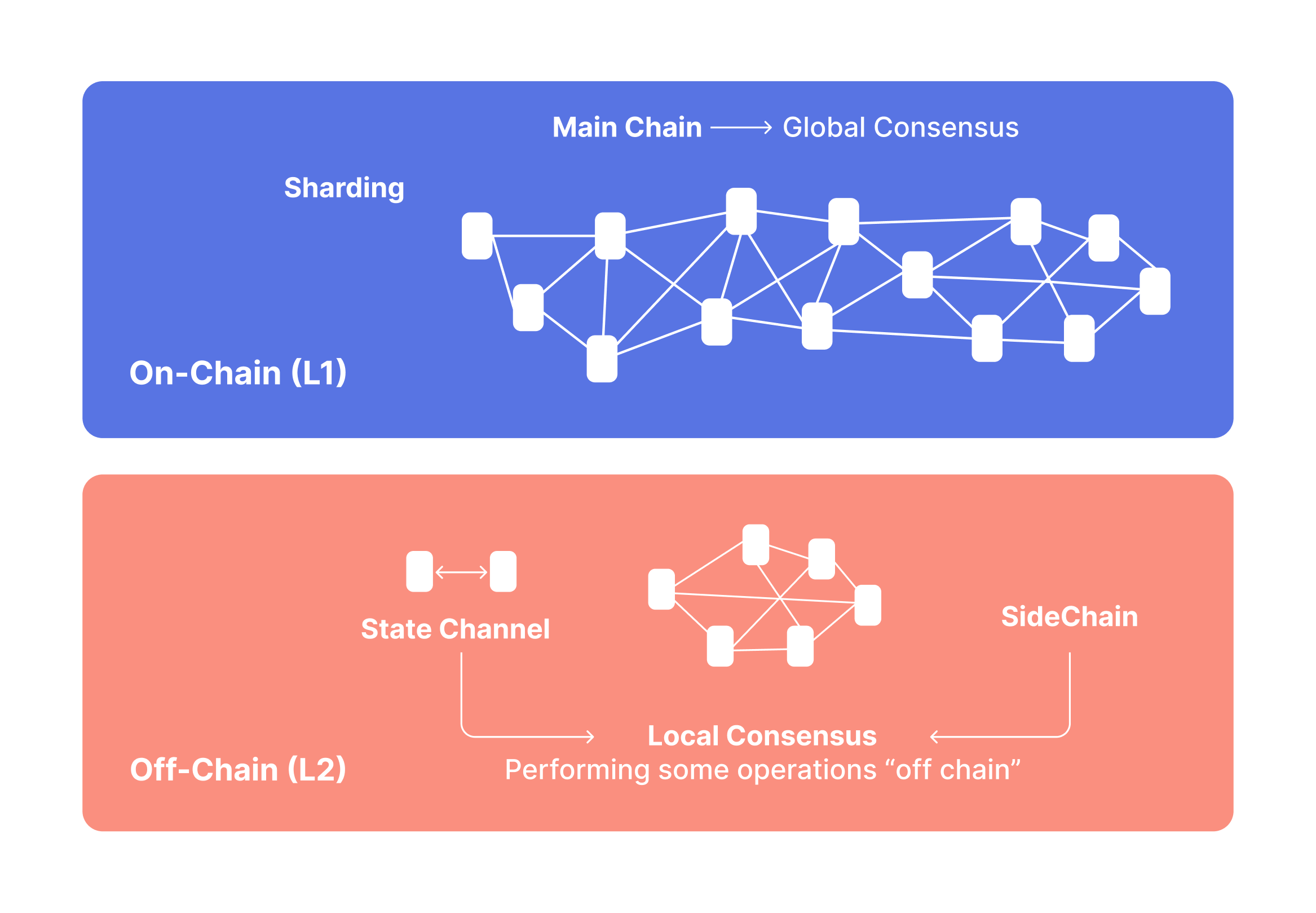

Ang isang praktikal na on-chain workflow ay nangangailangan ng dalawang layer: raw chain truth at enriched context.

A. Raw chain truth (canonical inputs)

Sa pinakamababa, planuhin na kolektahin:

Pro tip: tratuhin ang bawat dataset bilang isang versioned snapshot:

B. Enrichment (konteksto na kakailanganin mo para sa “kahulugan”)

Minimal reproducible schema (ano ang gusto mo sa iyong warehouse)

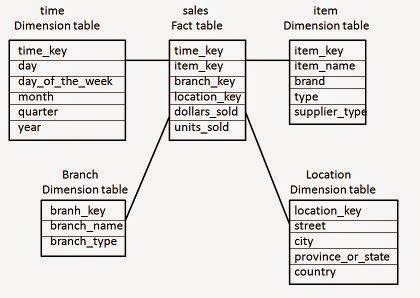

Isipin sa “fact tables” at “dimensions”:

fact_swaps(chain, block_time, tx_hash, pool, token_in, token_out, amount_in, amount_out, trader, fee_paid)fact_borrows(chain, block_time, market, borrower, asset, amount, rate_mode, health_factor)dim_address(address, label, type, confidence, source)dim_token(token, decimals, is_wrapped, underlying, risk_flags)dim_pool(pool, protocol, pool_type, fee_tier, token0, token1)Gumamit ng inline code na pangalan nang pare-pareho upang hindi masira ang mga downstream features.

Step 2: Normalize entities (addresses → actors)

Hindi nag-iisip ang mga AI models sa hex strings; natututo sila mula sa behavioral patterns. Ang iyong trabaho ay i-convert ang mga address sa matatag na “entities” kung posible.

Praktikal na labeling approach (mabilis → mas mabuti)

Magsimula sa tatlong antas:

Ano ang dapat itago para sa bawat label

label (hal., “MEV bot”, “protocol treasury”)confidence (0–1)evidence (mga patakarang na-trigger, heuristics, mga link)valid_from / valid_to (nagbabago ang mga label!)Wallet clustering: panatilihin itong konserbatibo

Ang clustering ay makakatulong (hal., pag-group ng mga address na kontrolado ng isang operator), ngunit maaari rin itong makasira sa iyong dataset kung mali.

| Entity task | Ano ang binubuksan nito | Karaniwang bitag |

|---|---|---|

| Pag-uuri ng kontrata | Mga tampok sa antas ng protocol | Nagpapalito ang mga pattern ng proxy/upgrade |

| Wallet clustering | Mga daloy ng cohort | Maling pagsasama mula sa mga ibinahaging tagapagpondo |

| Pagtukoy ng bot | Malinis na “organic” na signal | Paglipat ng label habang nag-aangkop ang mga bot |

| Pagtukoy sa treasury | Pagsusuri ng tunay na kita | Paghahalo ng treasury laban sa mga bayarin ng gumagamit |

Hakbang 3: Feature engineering para sa DeFi (ang “economic truth” layer)

Dito nagiging kapaki-pakinabang ang AI. Natututo ang iyong modelo mula sa mga tampok—kaya magdisenyo ng mga tampok na sumasalamin sa mga mekanismo, hindi lamang “mga numero.”

A. DEX & mga tampok ng liquidity (katotohanan ng pagpapatupad)

Kasama sa mga kapaki-pakinabang na tampok ang:

Matibay na patakaran: Kung mahalaga sa iyo ang tradability, i-modelo ang slippage sa ilalim ng stress, hindi “average daily volume.”

B. Mga tampok ng pagpapautang (insolvency & reflexivity)

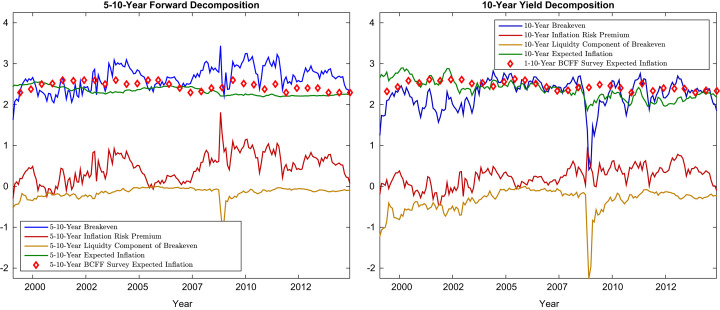

C. “Tunay na ani” vs ani ng insentibo (pundasyon ng sustainability)

Madalas na naghalo ang mga ani ng DeFi:

Isang praktikal na pagkakabuwal:

gross_yield = fee_yield + incentive_yieldreal_yield ≈ fee_yield - dilution_cost (kung saan ang dilution cost ay nakadepende sa konteksto, ngunit dapat mong subaybayan ang mga emission bilang porsyento ng market cap at paglago ng circulating supply)Pangunahing pananaw: ang sustainable yield ay bihirang pinakamataas na ani. Ito ang ani na nananatili kapag ang mga insentibo ay humina.

Hakbang 4: Lagyan ng label ang target (kung ano ang nais mong ipredict ng modelo)

Maraming dataset ng DeFi ang nabibigo dahil ang mga label ay malabo. Ang mga magandang target ay tiyak at nasusukat.

Mga halimbawa ng mga target ng modelo

Iwasan ang label leakage

Kung ang iyong label ay gumagamit ng impormasyon sa hinaharap (tulad ng isang susunod na eksploit), tiyakin na ang iyong mga tampok ay gumagamit lamang ng data na available bago ang kaganapan. Kung hindi, ang modelo ay “nangungurakot.”

Hakbang 5: Pumili ng tamang diskarte sa AI (at saan nababagay ang LLMs)

Iba't ibang mga tanong sa DeFi ang tumutugma sa iba't ibang pamilya ng modelo.

A. Pagtataya ng time-series (kapag mahalaga ang dynamics)

Gamitin kapag ikaw ay nagtataya ng:

B. Pag-uuri at pagraranggo (kapag pumipili ka ng “mga nangungunang kandidato”)

Gamitin kapag kailangan mo ng:

C. Pagtuklas ng anomaly (kapag hindi mo pa alam ang atake)

Kapaki-pakinabang para sa:

D. Pagkatuto ng graph (kapag ang mga relasyon ang signal)

Ang on-chain ay likas na isang graph: wallets ↔ contracts ↔ pools ↔ assets. Ang mga feature na batay sa graph ay maaaring lumampas sa mga patag na talahanayan para sa:

Saan tumutulong ang LLMs (at saan hindi)

Ang LLMs ay mahusay para sa:

Ang LLMs ay hindi kapalit para sa:

Isang praktikal na hybrid:

Hakbang 6: Pagsusuri at backtesting (ang hindi mapag-uusapan na bahagi)

Ang DeFi ay hindi nakatigil. Kung hindi mo ito susuriin nang maayos, ang iyong “signal” ay isang mirage.

A. Hatiin ayon sa oras, hindi nang random

Gamitin ang mga paghahati batay sa oras:

B. Subaybayan ang parehong katumpakan at kalidad ng desisyon

Sa DeFi, madalas mong pinahahalagahan ang ranking at panganib, hindi lamang ang “katumpakan.”

Isang simpleng checklist para sa pagsusuri

1. Tukuyin ang desisyon na patakaran (hal., “iwasan kung ang risk score > 0.7”)

2. Backtest gamit ang mga gastos sa transaksyon at slippage na mga palagay

3. Patakbuhin ang stress regimes (mataas na gas, mataas na volatility, kakulangan sa liquidity)

4. Ihambing laban sa mga baseline (madalas na nananalo ang mga simpleng heuristics)

5. Itago ang isang audit trail (mga tampok, bersyon ng modelo, snapshot blocks)

| Evaluation layer | What you measure | Why it matters |

|---|---|---|

| Predictive | AUC / error | Signal quality |

| Economic | PnL / drawdown / slippage | Real-world viability |

| Operational | latency / stability | Can it run daily? |

| Safety | false positives/negatives | Risk appetite alignment |

Hakbang 7: I-deploy bilang isang loop (hindi isang one-off na ulat)

Ang tunay na “praktikal na workflow” ay isang loop na maaari mong patakbuhin araw-araw/linggo.

Pangunahing production loop

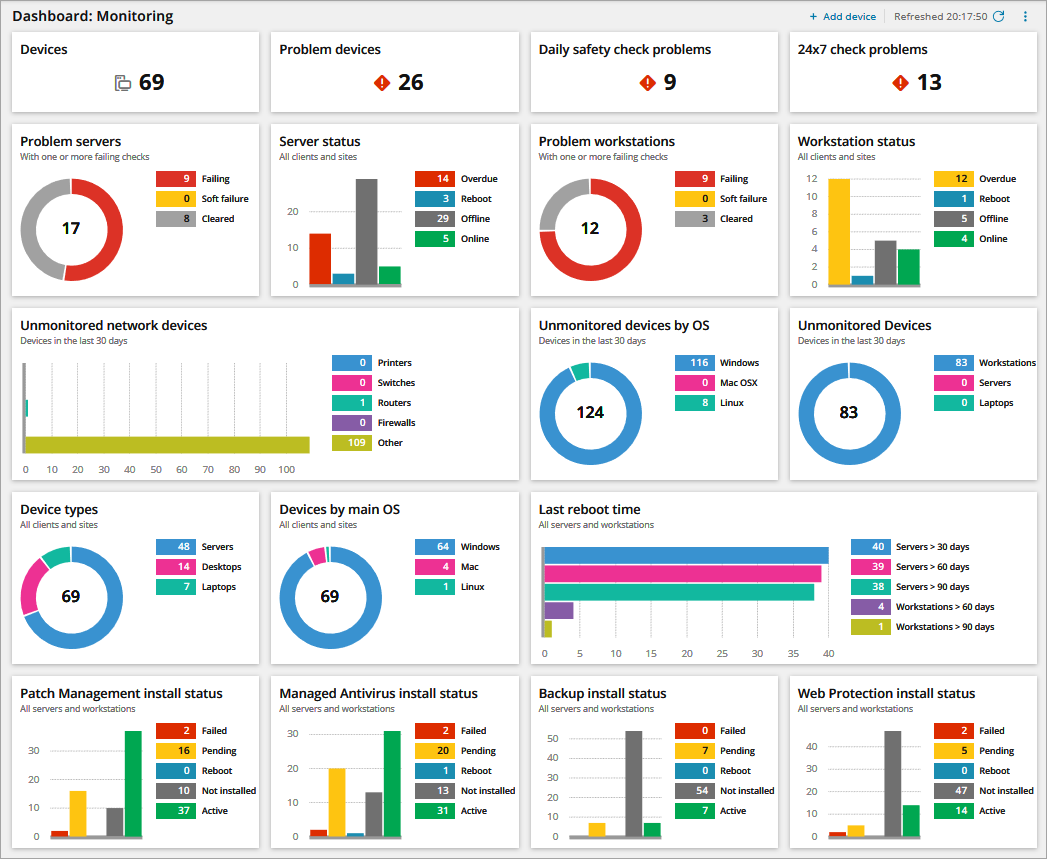

Pagsubaybay na mahalaga sa DeFi

Praktikal na patakaran: kung hindi mo maipaliwanag bakit nagbago ang score ng modelo, hindi mo ito mapagkakatiwalaan sa isang reflexive market.

Isang halimbawa: “Totoo ba ang APY na ito?”

Ilapat natin ang workflow sa isang karaniwang DeFi na bitag: kaakit-akit na mga ani na kadalasang mga insentibo.

Hakbang-hakbang

Kalkulahin:

fee_revenue_usd (mga bayarin sa kalakalan / interes sa pautang)incentives_usd (emisyon + suhol + gantimpala)net_inflows_usd (organiko ba o mercenary ang TVL?)user_return_estimate (kita mula sa bayarin bawas ang IL / mga gastos sa pautang kung kinakailangan)Isang simpleng ratio ng pagpapanatili:

fee_to_incentive = fee_revenue_usd / max(incentives_usd, 1)Pagsasalin:

fee_to_incentive > 1.0 kadalasang nagpapahiwatig ng ani na suportado ng bayarinfee_to_incentive < 0.3 nagpapahiwatig na nangingibabaw ang mga insentibo| Sukat | Ano ang sinasabi nito | Red flag threshold |

|---|---|---|

| feetoincentive | ani na suportado ng bayarin vs emisyon | < 0.3 |

| TVL churn | mercenary na likwididad | mataas na lingguhang churn |

| whale share | panganib ng konsentrasyon | nangungunang 5 > 40% |

| MEV intensity | pagkakalantad sa pagkilos | tumataas na sandwich rate |

| net fees per TVL | kahusayan | bumababang trend |

Magdagdag ng AI:

fee_revenue_usd sa ilalim ng maraming senaryo ng dami

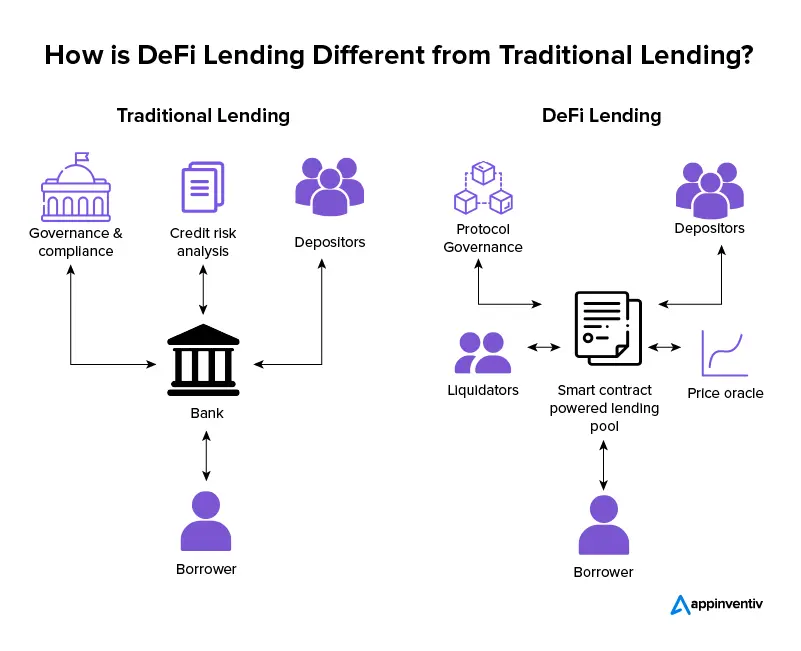

Paano gumagana ang AI para sa pagsusuri ng data ng DeFi sa chain?

AI para sa pagsusuri ng data ng DeFi ay gumagana sa chain sa pamamagitan ng pagbabago ng mga low-level na artifact ng blockchain (mga transaksyon, mga log, mga trace, at estado) sa mga katangian ng ekonomiya (mga bayarin, leverage, lalim ng likwididad, konsentrasyon ng panganib), pagkatapos ay natututo ng mga pattern na nagtataya ng mga resulta na maaari mong sukatin (sustainability ng yield, mga shock sa likwididad, panganib ng insolvency, anomalous na daloy). Ang bahagi ng “AI” ay kasing ganda lamang ng:

Kung ituturing mo ang workflow bilang isang paulit-ulit na sistema—tulad ng staged research approach na binigyang-diin sa SimianX-style multi-step analysis—makakakuha ka ng mga modelo na umuunlad sa paglipas ng panahon sa halip na mga brittle na one-off na pananaw.

Praktikal na tooling: isang minimal na stack na maaari mong talagang patakbuhin

Hindi mo kailangan ng malaking koponan, ngunit kailangan mo ng disiplina.

A. Layer ng Data

B. Layer ng Analytics

C. “Research agent” layer (opsyonal ngunit makapangyarihan)

Dito nagliliwanag ang multi-agent mindset:

Dito rin maaaring maging kapaki-pakinabang na mental model ang SimianX AI: sa halip na umasa sa isang solong “alam ang lahat” na pagsusuri, gumamit ng mga specialized perspectives at pilitin ang mga tahasang tradeoffs—pagkatapos ay mag-output ng isang malinaw, estrukturadong ulat. Maaari mong tuklasin ang platform approach sa SimianX AI.

Karaniwang mga paraan ng pagkabigo (at kung paano ito maiiwasan)

FAQ Tungkol sa AI para sa Pagsusuri ng Data ng DeFi: Isang Praktikal na On-Chain na Workflow

Paano bumuo ng on-chain na mga tampok para sa machine learning sa DeFi?

Magsimula mula sa mekanika ng protocol: i-map ang mga kaganapan sa ekonomiya (mga bayarin, utang, collateral, lalim ng likwididad). Gumamit ng rolling windows, iwasan ang leakage, at itago ang mga depinisyon ng tampok na may bersyoning upang ma-reproduce mo ang mga resulta.

Ano ang tunay na yield sa DeFi, at bakit ito mahalaga?

Ang tunay na yield ay yield na pangunahing sinusuportahan ng organikong kita ng protocol (mga bayarin/interes) sa halip na mga emissions ng token. Mahalaga ito dahil ang mga emissions ay maaaring mawala, habang ang mga bayad na nakabatay sa kita ay madalas na nananatili (bagaman maaari pa rin silang maging cyclical).

Ano ang pinakamahusay na paraan upang i-backtest ang mga signal ng DeFi nang hindi niloloko ang sarili?

Hatiin ayon sa oras, isama ang mga gastos sa transaksyon at slippage, at subukan sa iba't ibang stress regimes. Palaging ikumpara sa mga simpleng baseline; kung ang iyong modelo ay hindi kayang talunin ang isang heuristic nang maaasahan, malamang na ito ay overfit.

Maaari bang palitan ng LLMs ang quantitative on-chain analysis?

Maaari ng LLMs na pabilisin ang interpretasyon—pagsasummarize ng mga panukala, pagkuha ng mga palagay, pag-aayos ng mga checklist—ngunit hindi nila kayang palitan ang tamang pag-decode ng mga kaganapan, masusing pag-label, at pagsusuri batay sa oras. Gumamit ng LLMs upang i-structure ang pananaliksik, hindi upang “hallucinate” ang chain.

Paano ko matutukoy ang insentibo-driven (mercenary) na likwididad?

Subaybayan ang TVL churn, mga ratio ng bayad sa insentibo, at komposisyon ng wallet cohort. Kung ang likwididad ay lumilitaw kapag tumataas ang mga insentibo at mabilis na umalis pagkatapos, ituring ang ani bilang marupok maliban kung ang mga bayad ay nakapag-suporta dito nang nakapag-iisa.

Konklusyon

Ang AI ay nagiging tunay na mahalaga sa DeFi kapag binabago mo ang on-chain noise sa isang paulit-ulit na workflow: desisyon-unang pag-frame, reproducible datasets, konserbatibong pag-label ng entity, mekanismo-batay na mga tampok, time-split evaluation, at patuloy na pagmamanman. Sundin ang praktikal na on-chain loop na ito at makakabuo ka ng pagsusuri na maihahambing sa iba't ibang protocol, matibay sa mga pagbabago ng rehimen, at maipapaliwanag sa mga kasamahan o stakeholder.

Kung nais mo ng isang nakabalangkas na paraan upang magsagawa ng staged, multi-perspective na pananaliksik (at upang isalin ang kumplikadong data sa malinaw, maibabahaging mga output), tuklasin ang SimianX AI bilang isang modelo para sa pag-organisa ng masusing pagsusuri sa isang maaksiyong workflow.