IA pour l'analyse des données DeFi : Un flux de travail pratique sur la chaîne

IA pour l'analyse des données DeFi : Un flux de travail pratique sur la chaîne concerne la transformation de l'activité blockchain transparente mais désordonnée en recherche répétable : ensembles de données propres, caractéristiques défendables, hypothèses testables et modèles surveillés. Si vous avez déjà regardé des tableaux de bord TVL, des pages de rendement et des graphiques de tokens et pensé "cela semble flou", ce flux de travail est votre antidote. Et si vous aimez une analyse structurée et par étapes (la façon dont SimianX AI encadre les boucles de recherche en plusieurs étapes), vous pouvez apporter la même discipline au travail sur la chaîne afin que les résultats soient explicables, comparables entre les protocoles et faciles à itérer.

Pourquoi l'analyse des données sur la chaîne est plus difficile (et meilleure) qu'elle n'en a l'air

Les données sur la chaîne vous donnent la vérité fondamentale de ce qui s'est passé : transferts, échanges, emprunts, liquidations, staking, votes de gouvernance et flux de frais. Mais "vérité fondamentale" ne signifie pas "vérité facile". Les analystes DeFi rencontrent des problèmes comme :

Le potentiel est énorme : lorsque vous construisez un pipeline prêt pour l'IA, vous pouvez répondre à des questions avec des preuves, pas des impressions—puis continuer à exécuter le même flux de travail à mesure que les conditions changent.

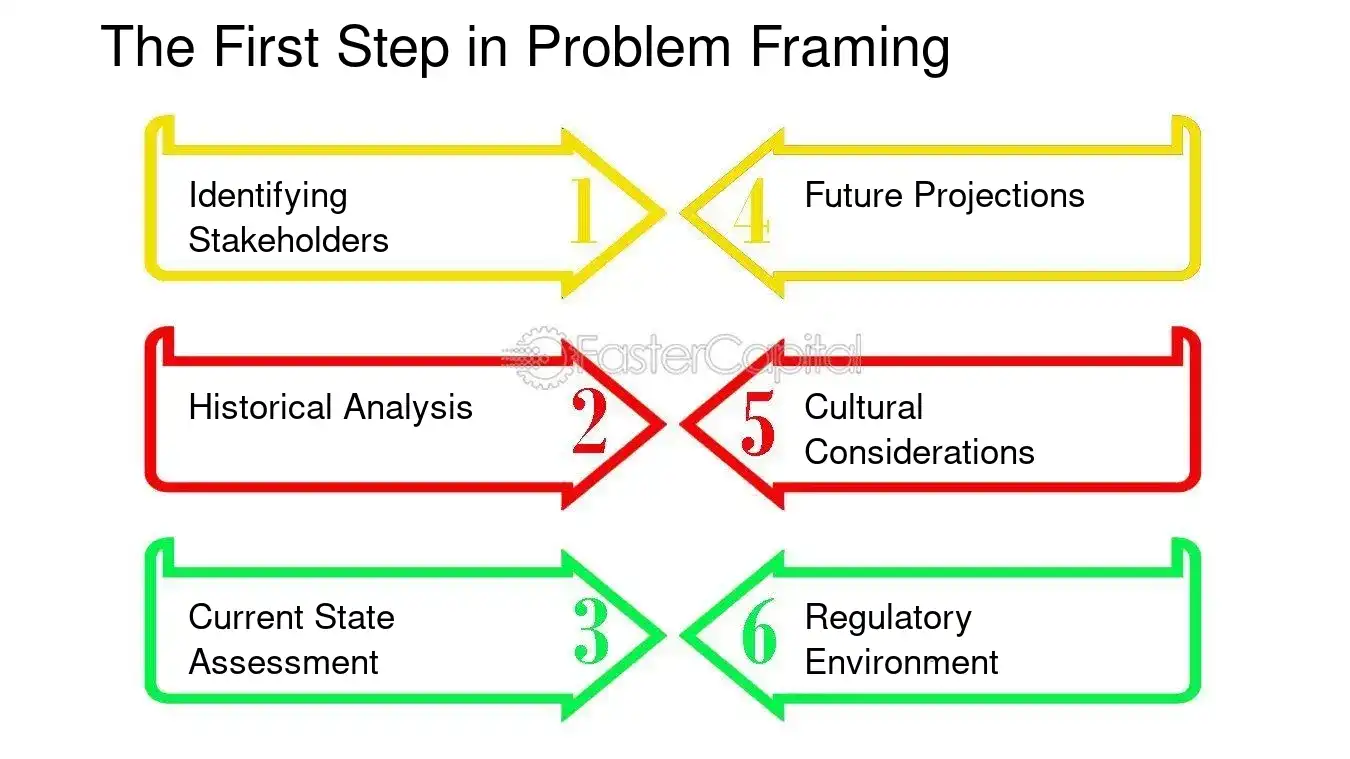

Étape 0 : Commencez par une décision, pas un ensemble de données

Le moyen le plus rapide de perdre du temps dans la DeFi est de « tout télécharger » et d'espérer que des motifs émergent. Au lieu de cela, définissez :

1. Décision : que ferez-vous différemment en fonction de l'analyse ?

2. Objet : protocole, pool, token, stratégie de coffre-fort ou cohorte de portefeuille ?

3. Horizon temporel : intrajournalier, hebdomadaire, trimestriel ?

4. Métrique de résultat : qu'est-ce qui compte comme succès ou échec ?

Exemples de décisions qui s'alignent bien avec l'IA

Insight clé : L'IA est la plus forte lorsque l'objectif est mesurable (par exemple, probabilité de drawdown, fréquence de liquidation, ratio frais/émissions), pas lorsque l'objectif est une « bonne narration ».

Étape 1 : Construisez votre fondation de données en chaîne (sources + reproductibilité)

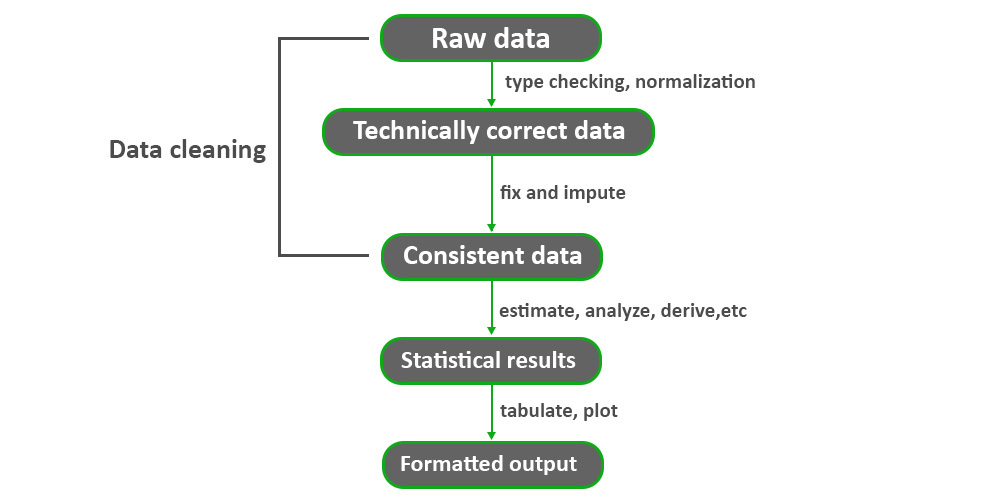

Un flux de travail pratique en chaîne nécessite deux couches : vérité brute de la chaîne et contexte enrichi.

A. Vérité brute de la chaîne (entrées canoniques)

Au minimum, prévoyez de collecter :

Conseil pro : considérez chaque ensemble de données comme un instantané versionné :

B. Enrichissement (contexte dont vous aurez besoin pour le “sens”)

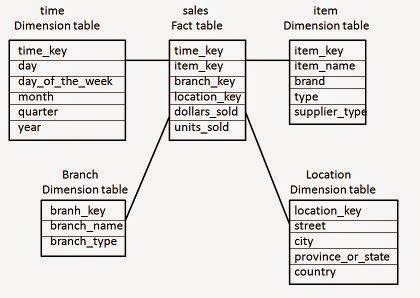

Schéma minimal reproductible (ce que vous voulez dans votre entrepôt)

Pensez en “tables de faits” et “dimensions” :

fact_swaps(chain, block_time, tx_hash, pool, token_in, token_out, amount_in, amount_out, trader, fee_paid)fact_borrows(chain, block_time, market, borrower, asset, amount, rate_mode, health_factor)dim_address(address, label, type, confidence, source)dim_token(token, decimals, is_wrapped, underlying, risk_flags)dim_pool(pool, protocol, pool_type, fee_tier, token0, token1)Utilisez inline code de manière cohérente afin que les fonctionnalités en aval ne soient pas rompues.

Étape 2 : Normaliser les entités (adresses → acteurs)

Les modèles d'IA ne pensent pas en chaînes hexadécimales ; ils apprennent à partir de schémas comportementaux. Votre travail consiste à convertir les adresses en “entités” stables lorsque cela est possible.

Approche de labellisation pratique (rapide → meilleure)

Commencez par trois niveaux :

Ce qu'il faut stocker pour chaque étiquette

label (par exemple, “bot MEV”, “trésorerie de protocole”)confidence (0–1)preuve (règles déclenchées, heuristiques, liens)valide_de / valide_à (les étiquettes changent !)Regroupement de portefeuilles : restez conservateur

Le regroupement peut aider (par exemple, regrouper des adresses contrôlées par un seul opérateur), mais il peut également empoisonner votre ensemble de données s'il est incorrect.

| Tâche d'entité | Ce qu'elle débloque | Piège courant |

|---|---|---|

| Classification des contrats | Fonctionnalités au niveau du protocole | Les modèles de proxy/mise à niveau induisent en erreur |

| Regroupement de portefeuilles | Flux de cohortes | Faux regroupements provenant de bailleurs de fonds partagés |

| Détection de bots | Signaux “organiques” propres | Dérive des étiquettes à mesure que les bots s'adaptent |

| Identification de trésorerie | Analyse du rendement réel | Mélange de trésorerie et de frais utilisateur |

Étape 3 : Ingénierie des fonctionnalités pour DeFi (la couche de “vérité économique”)

C'est ici que l'IA devient utile. Votre modèle apprend des fonctionnalités—donc concevez des fonctionnalités qui reflètent les mécanismes, pas seulement des “nombres.”

A. Fonctionnalités DEX et liquidité (réalité d'exécution)

Les fonctionnalités utiles incluent :

Règle en gras : Si vous vous souciez de la négociabilité, modélisez le glissement sous pression, pas “le volume quotidien moyen.”

B. Fonctionnalités de prêt (insolvabilité et réflexivité)

C. “Rendement réel” vs rendement incitatif (noyau de durabilité)

Les rendements DeFi mélangent souvent :

Une décomposition pratique :

rendement_brut = rendement_frais + rendement_incentifrendement_réel ≈ rendement_frais - coût_de_dilution (où le coût de dilution dépend du contexte, mais vous devriez au moins suivre les émissions en pourcentage de la capitalisation boursière et de la croissance de l'offre en circulation)Insight clé : le rendement durable est rarement le rendement le plus élevé. C'est le rendement qui survit lorsque les incitations diminuent.

Étape 4 : Étiquetez la cible (ce que vous voulez que le modèle prédit)

De nombreux ensembles de données DeFi échouent car les étiquettes sont vagues. De bonnes cibles sont spécifiques et mesurables.

Exemples de cibles de modèle

Évitez la fuite d'étiquettes

Si votre étiquette utilise des informations futures (comme une exploitation ultérieure), assurez-vous que vos caractéristiques n'utilisent que des données disponibles avant l'événement. Sinon, le modèle “triche”.

Étape 5 : Choisissez la bonne approche IA (et où les LLM s'intègrent)

Différentes questions DeFi correspondent à différentes familles de modèles.

A. Prévision de séries temporelles (quand la dynamique compte)

Utilisez lorsque vous prévoyez :

B. Classification et classement (quand vous choisissez les “meilleurs candidats”)

Utilisez lorsque vous avez besoin de :

C. Détection d'anomalies (quand vous ne connaissez pas encore l'attaque)

Utile pour :

D. Apprentissage par graphe (quand les relations sont le signal)

Sur la chaîne, c'est naturellement un graphe : portefeuilles ↔ contrats ↔ pools ↔ actifs. Les caractéristiques basées sur des graphes peuvent surpasser les tables plates pour :

Où les LLM aident (et où ils n'aident pas)

Les LLM sont excellents pour :

Les LLM ne sont pas un substitut pour :

Un hybride pratique :

Étape 6 : Évaluation et backtesting (la partie non négociable)

DeFi est non stationnaire. Si vous n'évaluez pas attentivement, votre “signal” est un mirage.

A. Diviser par le temps, pas aléatoirement

Utilisez des divisions basées sur le temps :

B. Suivez à la fois la précision et la qualité des décisions

Dans DeFi, vous vous souciez souvent du classement et du risque, pas seulement de l'“exactitude.”

Une liste de contrôle d'évaluation simple

1. Définir la règle de décision (par exemple, “éviter si le score de risque > 0,7”)

2. Tester avec des hypothèses de coûts de transaction et de slippage

3. Exécuter des régimes de stress (gaz élevé, forte volatilité, crise de liquidité)

4. Comparer avec des références (des heuristiques simples gagnent souvent)

5. Stocker une trace d'audit (caractéristiques, version du modèle, blocs instantanés)

| Couche d'évaluation | Ce que vous mesurez | Pourquoi c'est important |

|---|---|---|

| Prédictif | AUC / erreur | Qualité du signal |

| Économique | PnL / drawdown / slippage | Viabilité dans le monde réel |

| Opérationnel | latence / stabilité | Peut-il fonctionner quotidiennement ? |

| Sécurité | faux positifs/négatifs | Alignement avec l'appétit pour le risque |

Étape 7 : Déployer en boucle (pas un rapport ponctuel)

Un véritable “flux de travail pratique” est une boucle que vous pouvez exécuter chaque jour/semaine.

Boucle de production principale

Surveillance qui compte dans DeFi

Règle pratique : si vous ne pouvez pas expliquer pourquoi le modèle a changé son score, vous ne pouvez pas lui faire confiance dans un marché réflexif.

Un exemple concret : “Cet APY est-il réel ?”

Appliquons le flux de travail à un piège DeFi courant : des rendements attractifs qui sont principalement des incitations.

Étape par étape

Calculer :

fee_revenue_usd (frais de trading / intérêts d'emprunt)incentives_usd (émissions + pots-de-vin + récompenses)net_inflows_usd (le TVL est-il organique ou mercenaire ?)user_return_estimate (revenu des frais moins IL / coûts d'emprunt le cas échéant)Un simple ratio de durabilité :

fee_to_incentive = fee_revenue_usd / max(incentives_usd, 1)Interprétation :

fee_to_incentive > 1.0 indique souvent un rendement soutenu par des fraisfee_to_incentive < 0.3 suggère que les incitations dominent| Métrique | Ce que cela vous dit | Seuil d'alerte |

|---|---|---|

| feetoincentive | rendement soutenu par des frais vs émissions | < 0.3 |

| rotation du TVL | liquidité mercenaire | forte rotation hebdomadaire |

| part des baleines | risque de concentration | top 5 > 40% |

| intensité MEV | toxicité d'exécution | taux de sandwich en hausse |

| frais nets par TVL | efficacité | tendance à la baisse |

Ajouter de l'IA :

fee_revenue_usd sous plusieurs scénarios de volume

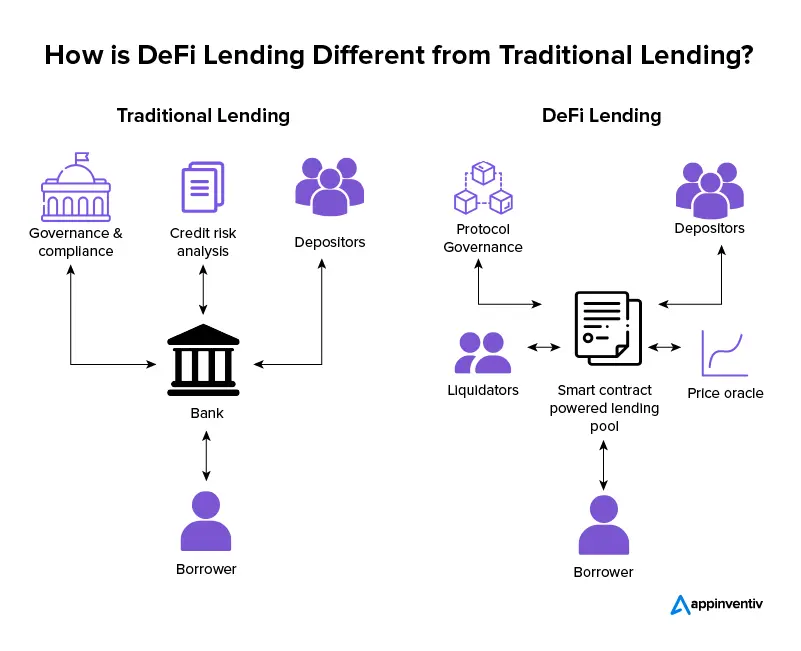

Comment l'IA pour l'analyse des données DeFi fonctionne-t-elle sur la chaîne ?

L'IA pour l'analyse des données DeFi fonctionne sur la chaîne en transformant des artefacts de blockchain de bas niveau (transactions, journaux, traces et état) en caractéristiques économiques (frais, effet de levier, profondeur de liquidité, concentration de risque), puis en apprenant des modèles qui prédisent des résultats que vous pouvez mesurer (durabilité des rendements, chocs de liquidité, risque d'insolvabilité, flux anormaux). La partie "IA" n'est aussi bonne que :

Si vous traitez le flux de travail comme un système répétable—comme l'approche de recherche par étapes mise en avant dans l'analyse multi-étapes de style SimianX—vous obtenez des modèles qui s'améliorent avec le temps au lieu d'insights fragiles et ponctuels.

Outils pratiques : une pile minimale que vous pouvez réellement exécuter

Vous n'avez pas besoin d'une grande équipe, mais vous avez besoin de discipline.

A. Couche de données

B. Couche d'analytique

C. Couche "agent de recherche" (optionnelle mais puissante)

C'est ici qu'un état d'esprit multi-agent brille :

C'est également ici que SimianX AI peut être un modèle mental utile : au lieu de s'appuyer sur une seule analyse "omnisciente", utilisez des perspectives spécialisées et forcez des compromis explicites—puis produisez un rapport clair et structuré. Vous pouvez explorer l'approche de la plateforme sur SimianX AI.

Modes de défaillance courants (et comment les éviter)

FAQ sur l'IA pour l'analyse des données DeFi : un workflow pratique sur la chaîne

Comment construire des fonctionnalités sur la chaîne pour l'apprentissage automatique dans DeFi ?

Commencez par la mécanique du protocole : mappez les événements à l'économie (frais, dettes, collatéral, profondeur de liquidité). Utilisez des fenêtres glissantes, évitez les fuites et stockez les définitions de fonctionnalités avec versionnage afin de pouvoir reproduire les résultats.

Qu'est-ce que le rendement réel dans DeFi, et pourquoi est-ce important ?

Le rendement réel est un rendement principalement soutenu par les revenus organiques du protocole (frais/intérêts) plutôt que par les émissions de jetons. C'est important car les émissions peuvent s'estomper, tandis que les rendements soutenus par les frais persistent souvent (bien qu'ils puissent encore être cycliques).

Quelle est la meilleure façon de backtester les signaux DeFi sans se tromper ?

Divisez par le temps, incluez les coûts de transaction et le slippage, et testez à travers des régimes de stress. Comparez toujours à des références simples ; si votre modèle ne peut pas battre une heuristique de manière fiable, il est probablement surajusté.

Les LLM peuvent-ils remplacer l'analyse quantitative sur la chaîne ?

Les LLM peuvent accélérer l'interprétation—résumant des propositions, extrayant des hypothèses, organisant des listes de contrôle—mais ils ne peuvent pas remplacer le décodage correct des événements, le marquage rigoureux et l'évaluation basée sur le temps. Utilisez les LLM pour structurer la recherche, pas pour "halluciner" la chaîne.

Comment détecter la liquidité motivée par des incitations (mercenaire) ?

Suivez le taux de désabonnement de la TVL, les ratios frais/incitations et la composition des cohortes de portefeuilles. Si la liquidité apparaît lorsque les incitations augmentent et disparaît rapidement par la suite, considérez le rendement comme fragile à moins que les frais ne le soutiennent indépendamment.

Conclusion

L'IA devient véritablement précieuse dans la DeFi lorsque vous transformez le bruit on-chain en un flux de travail répétable : cadrage axé sur la décision, ensembles de données reproductibles, étiquetage conservateur des entités, caractéristiques basées sur des mécanismes, évaluation par découpage temporel et surveillance continue. Suivez cette boucle pratique on-chain et vous produirez une analyse comparable à travers les protocoles, résiliente aux changements de régime et explicable à vos coéquipiers ou parties prenantes.

Si vous souhaitez une manière structurée de mener des recherches par étapes et sous plusieurs perspectives (et de traduire des données complexes en résultats clairs et partageables), explorez SimianX AI comme modèle pour organiser une analyse rigoureuse en un flux de travail actionnable.