DeFi 데이터 분석을 위한 AI: 실용적인 온체인 워크플로우

DeFi 데이터 분석을 위한 AI: 실용적인 온체인 워크플로우는 투명하지만 복잡한 블록체인 활동을 반복 가능한 연구로 전환하는 것에 관한 것입니다: 깨끗한 데이터셋, 방어 가능한 특성, 테스트 가능한 가설, 그리고 모니터링된 모델. 만약 당신이 TVL 대시보드, 수익 페이지, 그리고 토큰 차트를 보고 “이건 손으로 대충 하는 것 같아”라고 생각한 적이 있다면, 이 워크플로우가 당신의 해독제입니다. 그리고 만약 당신이 구조적이고 단계적인 분석을 좋아한다면(SimianX AI가 다단계 연구 루프를 구성하는 방식처럼), 동일한 규율을 온체인 작업에 적용하여 결과가 설명 가능하고, 프로토콜 간 비교 가능하며, 반복하기 쉬운 결과를 얻을 수 있습니다.

온체인 데이터 분석이 더 어렵고(더 나은) 이유

온체인 데이터는 발생한 일에 대한 근본적인 진실을 제공합니다: 전송, 스왑, 대출, 청산, 스테이킹, 거버넌스 투표, 그리고 수수료 흐름. 하지만 “근본적인 진실”이 “쉬운 진실”을 의미하지는 않습니다. DeFi 분석가는 다음과 같은 문제에 직면합니다:

장점은 큽니다: AI 준비가 된 파이프라인을 구축하면, 증거로 질문에 답할 수 있으며, 기분이 아니라—조건이 변할 때마다 동일한 워크플로우를 계속 실행할 수 있습니다.

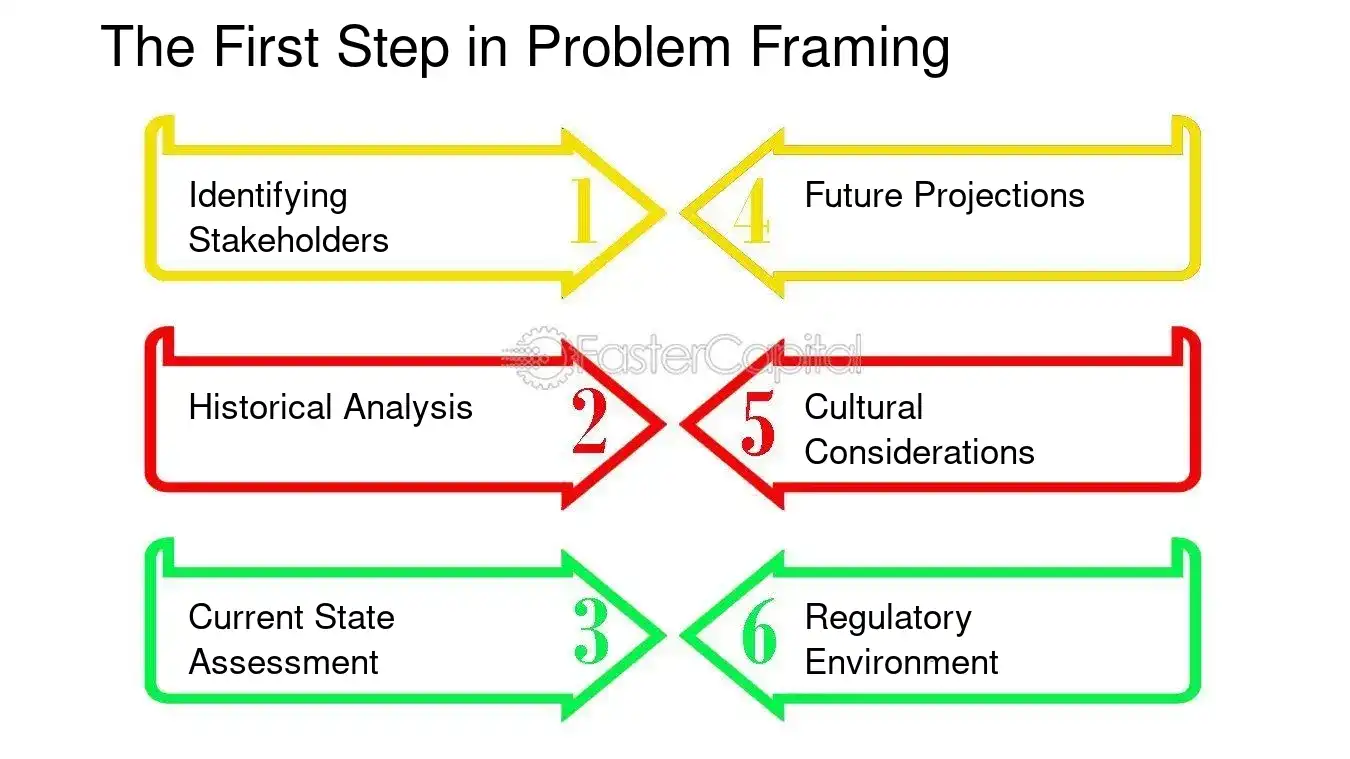

단계 0: 데이터셋이 아닌 결정을 시작하라

DeFi에서 시간을 낭비하는 가장 빠른 방법은 “모든 것을 다운로드”하고 패턴이 나타나기를 바라는 것입니다. 대신, 다음을 정의하십시오:

1. 결정: 분석에 따라 무엇을 다르게 할 것인가?

2. 대상: 프로토콜, 풀, 토큰, 금고 전략 또는 지갑 집단?

3. 시간 범위: 일일, 주간, 분기별?

4. 결과 지표: 성공 또는 실패로 간주되는 것은 무엇인가?

AI에 잘 매핑되는 예시 결정들

주요 통찰: AI는 목표가 측정 가능할 때 가장 강력하다 (예: 드로우다운 확률, 청산 빈도, 수수료 대 배출 비율), 목표가 “좋은 서사”일 때는 아니다.

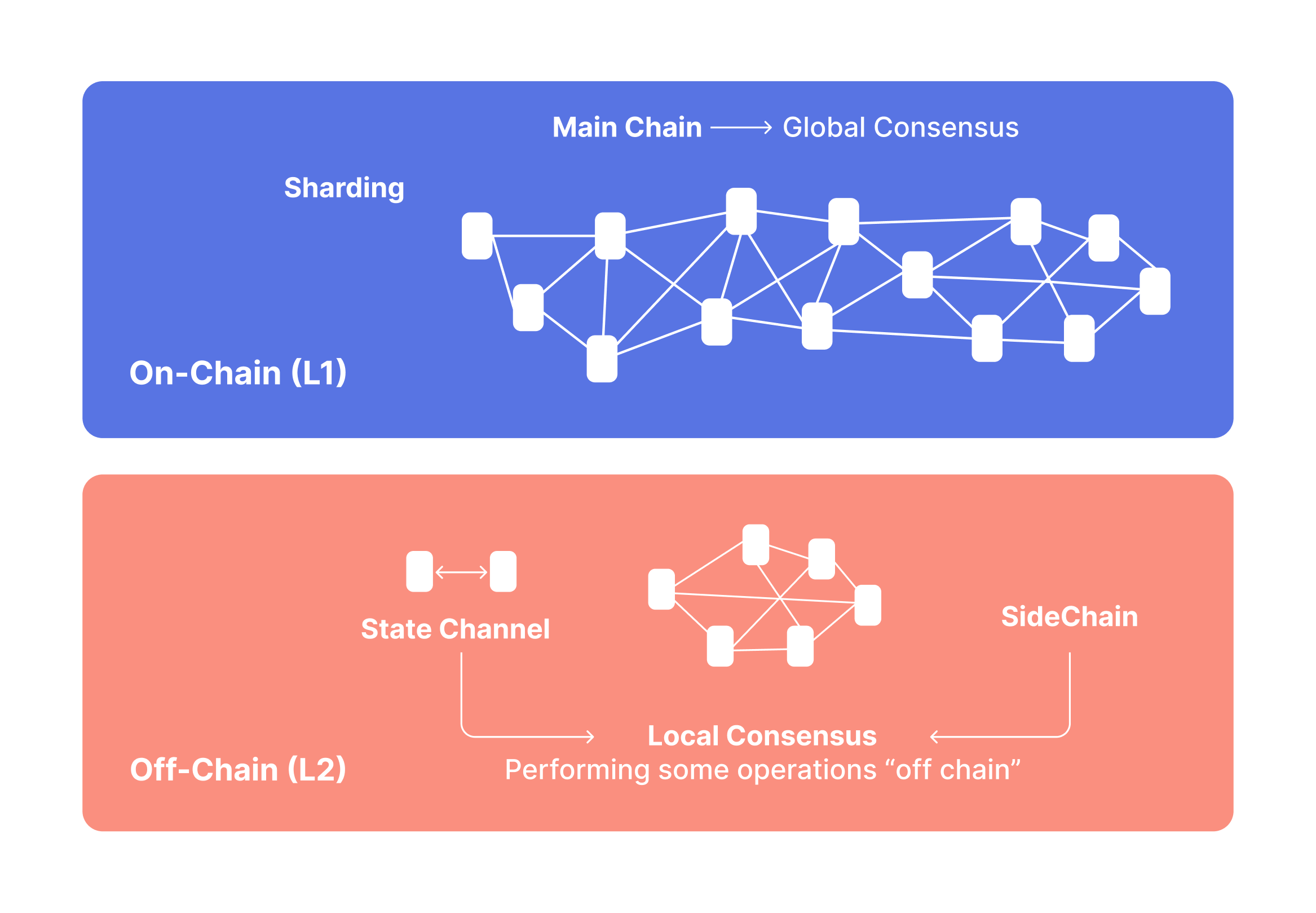

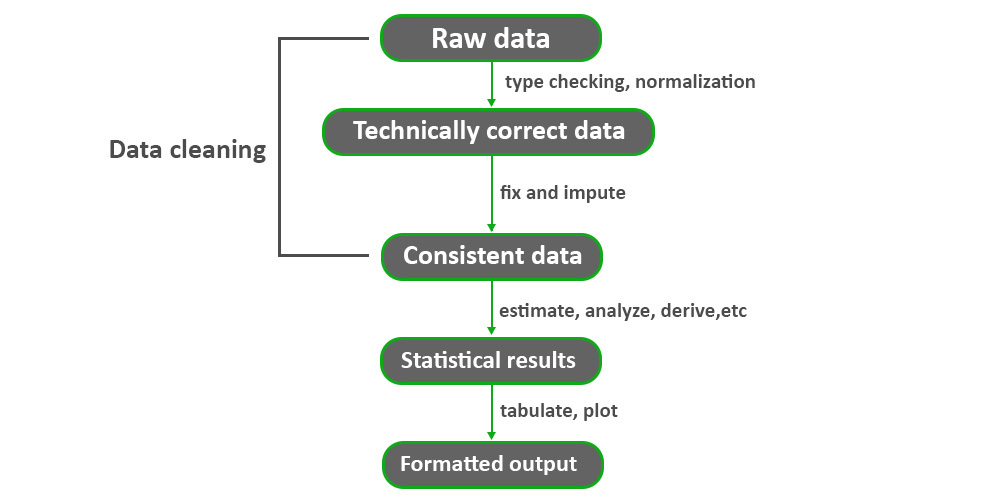

단계 1: 온체인 데이터 기반 구축 (출처 + 재현성)

실용적인 온체인 워크플로우는 두 가지 층이 필요합니다: 원시 체인 진실과 풍부한 맥락.

A. 원시 체인 진실 (정통 입력)

최소한 다음을 수집할 계획을 세우십시오:

전문가 팁: 모든 데이터 세트를 버전 관리된 스냅샷으로 취급하세요:

B. 보강(“의미”에 필요한 맥락)

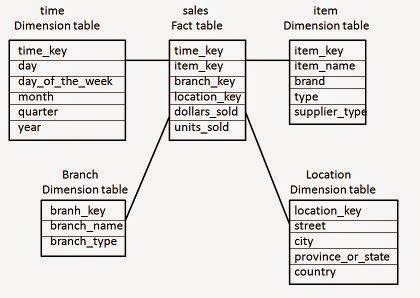

최소 재현 가능한 스키마(창고에서 원하는 것)

“팩트 테이블”과 “차원”으로 생각하세요:

fact_swaps(chain, block_time, tx_hash, pool, token_in, token_out, amount_in, amount_out, trader, fee_paid)fact_borrows(chain, block_time, market, borrower, asset, amount, rate_mode, health_factor)dim_address(address, label, type, confidence, source)dim_token(token, decimals, is_wrapped, underlying, risk_flags)dim_pool(pool, protocol, pool_type, fee_tier, token0, token1)일관되게 인라인 코드 명명법을 사용하여 하류 기능이 중단되지 않도록 하세요.

2단계: 엔티티 정규화(주소 → 행위자)

AI 모델은 16진수 문자열로 생각하지 않습니다; 그들은 행동 패턴에서 학습합니다. 귀하의 임무는 가능한 경우 주소를 안정적인 “엔티티”로 변환하는 것입니다.

실용적인 라벨링 접근법(빠름 → 더 나음)

세 가지 계층으로 시작하세요:

모든 라벨에 대해 저장할 내용

label(예: “MEV 봇”, “프로토콜 재무”)confidence(0–1)evidence (규칙 트리거, 휴리스틱, 링크)valid_from / valid_to (레이블 변경!)지갑 클러스터링: 보수적으로 유지하기

클러스터링은 도움이 될 수 있지만(예: 하나의 운영자가 제어하는 주소 그룹화), 잘못된 경우 데이터셋을 오염시킬 수 있습니다.

| 엔티티 작업 | 잠금 해제하는 것 | 일반적인 함정 |

|---|---|---|

| 계약 분류 | 프로토콜 수준 기능 | 프록시/업그레이드 패턴 오도 |

| 지갑 클러스터링 | 코호트 흐름 | 공유 기부자로 인한 잘못된 병합 |

| 봇 탐지 | 깨끗한 “유기적” 신호 | 봇이 적응함에 따라 레이블 드리프트 |

| 재무 식별 | 실제 수익 분석 | 재무와 사용자 수수료 혼합 |

3단계: DeFi를 위한 기능 엔지니어링 (“경제적 진실” 레이어)

여기서 AI가 유용해집니다. 모델은 기능에서 학습하므로 메커니즘을 반영하는 기능을 설계하세요, 단순히 “숫자”가 아닙니다.

A. DEX 및 유동성 기능 (실행 현실)

유용한 기능에는 다음이 포함됩니다:

강력한 규칙: 거래 가능성을 중요시한다면, 스트레스 하의 슬리피지를 모델링하세요, “평균 일일 거래량”이 아닙니다.

B. 대출 기능 (파산 및 반사성)

C. “실질 수익” 대 인센티브 수익 (지속 가능성 핵심)

DeFi 수익은 종종 혼합됩니다:

실용적인 분해:

gross_yield = fee_yield + incentive_yieldreal_yield ≈ fee_yield - dilution_cost (여기서 희석 비용은 맥락에 따라 다르지만, 최소한 배출량을 시가 총액 및 유통 공급 성장의 비율로 추적해야 합니다)주요 통찰: 지속 가능한 수익은 드물게 가장 높은 수익입니다. 인센티브가 줄어들 때 생존하는 수익입니다.

4단계: 목표 레이블 지정 (모델이 예측하기 원하는 것)

많은 DeFi 데이터 세트는 레이블이 모호하여 실패합니다. 좋은 목표는 구체적이고 측정 가능해야 합니다.

모델 목표의 예

레이블 유출 방지

레이블이 미래 정보를 사용하는 경우(예: 나중에 발생하는 착취), 이벤트 이전에 사용 가능한 데이터만 기능으로 사용하도록 하십시오. 그렇지 않으면 모델이 “속임수”를 씁니다.

5단계: 올바른 AI 접근 방식 선택 (LLM이 적합한 곳)

다양한 DeFi 질문은 서로 다른 모델 계열에 매핑됩니다.

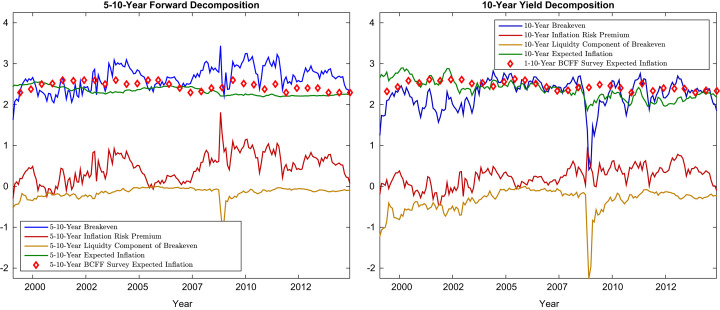

A. 시계열 예측 (동적이 중요한 경우)

예측할 때 사용:

B. 분류 및 순위 매기기 (“상위 후보”를 선택할 때)

필요할 때 사용:

C. 이상 탐지 (아직 공격을 모를 때)

유용한 경우:

D. 그래프 학습 (관계가 신호일 때)

온체인은 자연스럽게 그래프입니다: 지갑 ↔ 계약 ↔ 풀 ↔ 자산. 그래프 기반 기능은 다음과 같은 경우에 평면 테이블보다 더 나은 성능을 발휘할 수 있습니다:

LLM이 도움이 되는 곳 (그리고 도움이 되지 않는 곳)

LLM은 다음에 유용합니다:

LLM은 대체할 수 없는 것입니다:

실용적인 하이브리드:

6단계: 평가 및 백테스팅 (협상할 수 없는 부분)

DeFi는 비정상적입니다. 신중하게 평가하지 않으면 “신호”는 신기루입니다.

A. 무작위가 아닌 시간으로 분할

시간 기반 분할을 사용:

B. 정확도와 결정 품질 모두 추적

DeFi에서는 순위와 위험에 대해 신경 쓰는 경우가 많으며, 단순히 “정확성”만을 고려하지 않습니다.

간단한 평가 체크리스트

1. 결정 규칙 정의하기 (예: “위험 점수가 0.7 초과 시 회피”)

2. 거래 비용 및 슬리피지 가정으로 백테스트 수행

3. 스트레스 레짐 실행하기 (높은 가스, 높은 변동성, 유동성 위기)

4. 기준선과 비교하기 (간단한 휴리스틱이 종종 승리함)

5. 감사 추적 저장하기 (특징, 모델 버전, 스냅샷 블록)

| 평가 레이어 | 측정 항목 | 중요성 |

|---|---|---|

| 예측 | AUC / 오류 | 신호 품질 |

| 경제 | PnL / 하락 / 슬리피지 | 실제 세계의 실행 가능성 |

| 운영 | 지연 / 안정성 | 매일 실행할 수 있는가? |

| 안전 | 허위 긍정/부정 | 위험 선호도 정렬 |

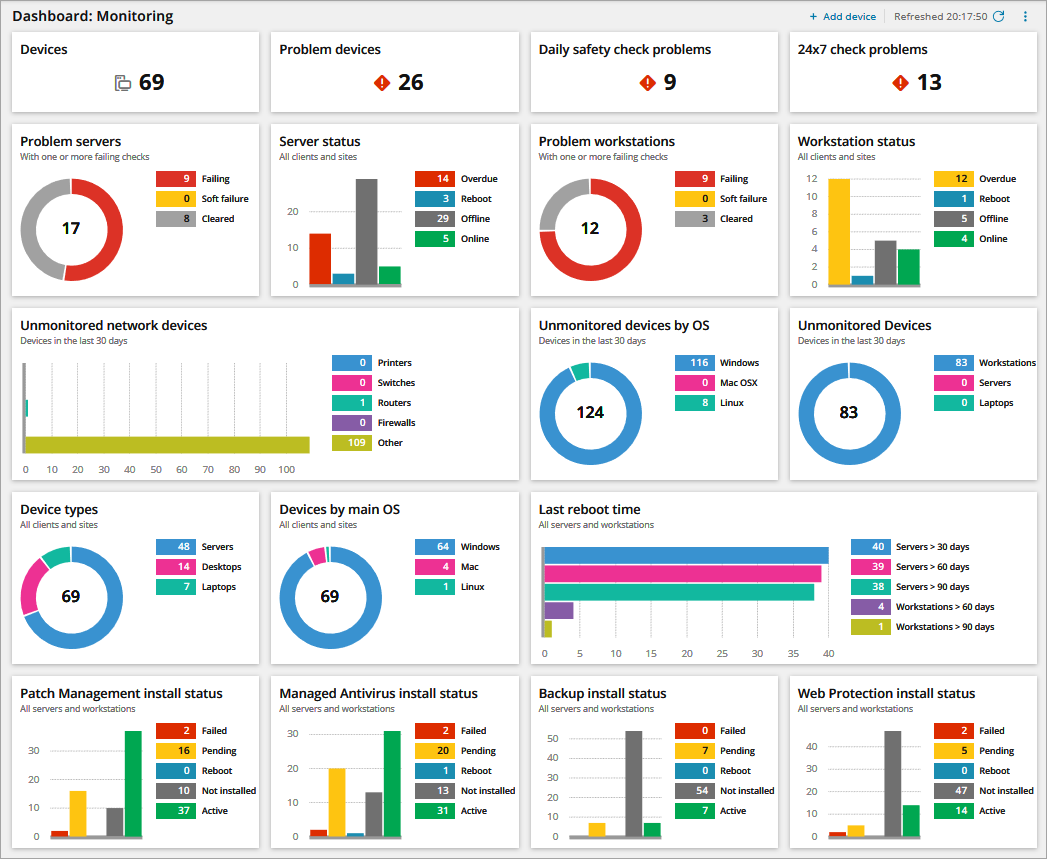

7단계: 루프로 배포하기 (일회성 보고서가 아님)

실제 “실용적인 워크플로우”는 매일/매주 실행할 수 있는 루프입니다.

핵심 생산 루프

DeFi에서 중요한 모니터링

실용적인 규칙: 모델이 점수를 변경한 이유를 설명할 수 없다면, 반응 시장에서 신뢰할 수 없다.

작업 예시: “이 APY는 진짜인가?”

일반적인 DeFi 함정인 매력적인 수익률이 대부분 인센티브인 경우에 이 워크플로를 적용해 봅시다.

단계별

계산:

fee_revenue_usd (거래 수수료 / 대출 이자)incentives_usd (배출량 + 뇌물 + 보상)net_inflows_usd (TVL이 유기적인가 아니면 용병인가?)user_return_estimate (수수료 수익에서 IL / 관련 대출 비용을 뺀 값)간단한 지속 가능성 비율:

fee_to_incentive = fee_revenue_usd / max(incentives_usd, 1)해석:

fee_to_incentive > 1.0은 종종 수수료 지원 수익률을 나타냅니다.fee_to_incentive < 0.3은 인센티브가 지배적임을 시사합니다.| 메트릭 | 설명 | 적신호 기준 |

|---|---|---|

| feetoincentive | 수수료 지원 vs 배출량 | < 0.3 |

| TVL 변동 | 용병 유동성 | 높은 주간 변동 |

| 고래 점유율 | 집중 위험 | 상위 5개 > 40% |

| MEV 강도 | 실행 독성 | 상승하는 샌드위치 비율 |

| TVL당 순수수료 | 효율성 | 하락 추세 |

AI 추가:

fee_revenue_usd 예측

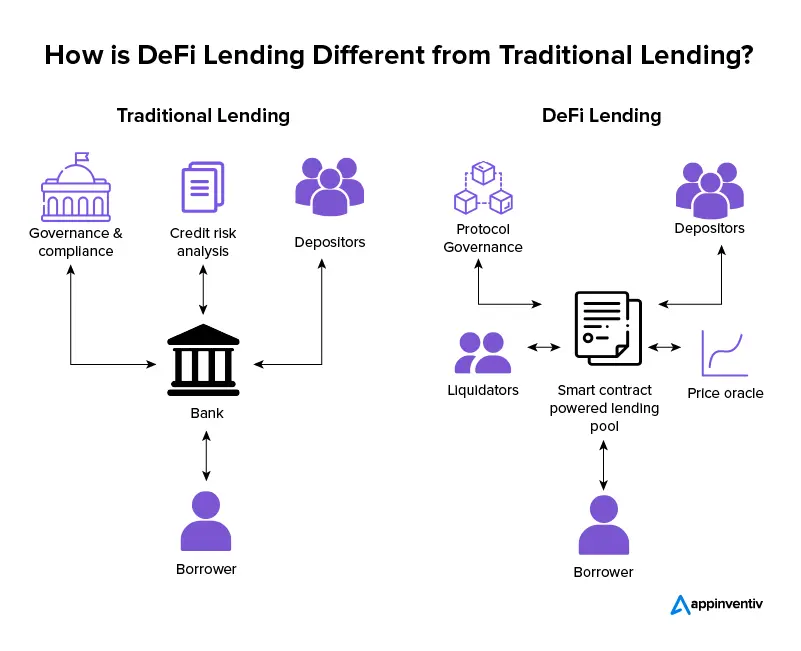

DeFi 데이터 분석을 위한 AI는 온체인에서 어떻게 작동하나요?

AI for DeFi 데이터 분석은 온체인에서 저수준 블록체인 아티팩트(거래, 로그, 추적 및 상태)를 경제적 특징(수수료, 레버리지, 유동성 깊이, 위험 집중)으로 변환한 다음, 측정할 수 있는 결과(수익 지속 가능성, 유동성 충격, 파산 위험, 비정상 흐름)를 예측하는 패턴을 학습합니다. “AI” 부분은 다음과 같은 요소만큼 좋습니다:

워크플로우를 반복 가능한 시스템으로 취급하면—SimianX 스타일의 다단계 분석에서 강조된 단계적 연구 접근 방식처럼—시간이 지남에 따라 개선되는 모델을 얻을 수 있습니다. 대신 부서지기 쉬운 일회성 통찰력을 얻는 것입니다.

실용적인 도구: 실제로 실행할 수 있는 최소 스택

거대한 팀이 필요하지는 않지만, 규율이 필요합니다.

A. 데이터 레이어

B. 분석 레이어

C. “연구 에이전트” 레이어 (선택 사항이지만 강력함)

여기서 다중 에이전트 사고방식이 빛을 발합니다:

여기서 SimianX AI가 유용한 사고 모델이 될 수 있습니다: 단일 “모든 것을 아는” 분석에 의존하는 대신, 전문화된 관점을 사용하고 명시적인 트레이드오프를 강요한 다음, 명확하고 구조화된 보고서를 출력합니다. 플랫폼 접근 방식은 SimianX AI에서 탐색할 수 있습니다.

일반적인 실패 모드 (그리고 이를 피하는 방법)

DeFi 데이터 분석을 위한 AI에 대한 FAQ: 실용적인 온체인 워크플로우

DeFi에서 기계 학습을 위한 온체인 기능을 어떻게 구축하나요?

프로토콜 메커니즘에서 시작하라: 이벤트를 경제학(수수료, 부채, 담보, 유동성 깊이)에 매핑하라. 롤링 윈도우를 사용하고, 누수를 피하며, 결과를 재현할 수 있도록 버전 관리와 함께 기능 정의를 저장하라.

DeFi에서 실제 수익이란 무엇이며, 왜 중요한가요?

실제 수익은 주로 유기적인 프로토콜 수익(수수료/이자)에 의해 뒷받침되는 수익이다. 이는 배출이 사라질 수 있는 반면, 수수료 기반의 수익은 종종 지속되기 때문에 중요하다(비록 여전히 주기적일 수 있다).

자신을 속이지 않고 DeFi 신호를 백테스트하는 가장 좋은 방법은 무엇인가요?

시간에 따라 나누고, 거래 비용과 슬리피지를 포함하며, 스트레스 체제에서 테스트하라. 항상 간단한 기준선과 비교하라; 만약 당신의 모델이 휴리스틱을 신뢰성 있게 이길 수 없다면, 아마도 과적합일 것이다.

LLM이 정량적 온체인 분석을 대체할 수 있나요?

LLM은 해석 속도를 높일 수 있다—제안 요약, 가정 추출, 체크리스트 조직 등—but 올바른 이벤트 디코딩, 엄격한 라벨링 및 시간 기반 평가를 대체할 수는 없다. LLM을 사용하여 연구를 구조화하라, 체인을 “환각”하지 않도록 하라.

인센티브 기반(용병) 유동성을 어떻게 감지하나요?

TVL 이탈, 수수료 대 인센티브 비율, 그리고 지갑 집단 구성을 추적하세요. 인센티브가 급증할 때 유동성이 나타나고 그 후 빠르게 사라진다면, 수수료가 독립적으로 이를 지원하지 않는 한 수익률을 취약한 것으로 간주하세요.

결론

AI는 온체인 노이즈를 반복 가능한 워크플로우로 전환할 때 DeFi에서 진정으로 가치 있게 됩니다: 결정 중심 프레이밍, 재현 가능한 데이터셋, 보수적인 엔티티 레이블링, 메커니즘 기반 기능, 시간 분할 평가, 그리고 지속적인 모니터링. 이 실용적인 온체인 루프를 따르시면 프로토콜 간 비교 가능한 분석을 생성하고, 체제 변화에 강하며, 팀원이나 이해관계자에게 설명할 수 있는 분석을 만들 수 있습니다.

단계적이고 다각적인 연구를 수행하는 구조화된 방법(그리고 복잡한 데이터를 명확하고 공유 가능한 출력으로 변환하는 방법)을 원하신다면, SimianX AI를 탐색하여 엄격한 분석을 실행 가능한 워크플로우로 조직하는 모델로 활용해 보세요.